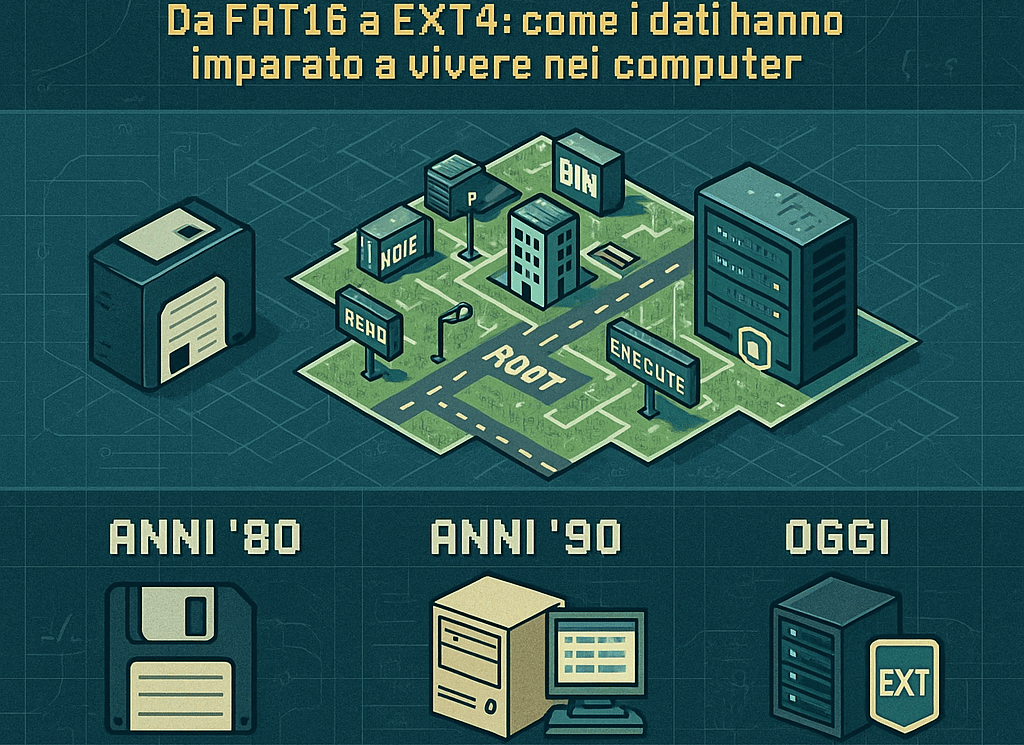

La Storia dei File System: Un Viaggio nelle Fondamenta Invisibili del Mondo Digitale

Scopri la storia dei file system: da FAT a NTFS ed EXT4. Come l'evoluzione dell'archiviazione dati ha plasmato l'informatica moderna. Guida completa ai sistemi di file.

IN PRIMA PAGINARETI E INFRASTRUTTURE DIGITALICULTURA E FILOSOFIA DIGITALE

La Storia dei File System:

Un Viaggio nelle Fondamenta Invisibili del Mondo Digitale

Come l'evoluzione dell'archiviazione dati ha plasmato l'informatica moderna

Prefazione:

I Custodi Silenziosi dei Nostri Dati

C'è un paradosso affascinante nel mondo dell'informatica: le tecnologie più importanti sono spesso quelle che notiamo meno. I file system appartengono a questa categoria. Ogni volta che salvi un documento, copi una foto, o semplicemente accendi il computer, un sofisticato sistema di organizzazione lavora nell'ombra, traducendo i tuoi comandi in sequenze di bit ordinati su un supporto magnetico, ottico o a stato solido.

Immagina una biblioteca infinita, con miliardi di libri in continuo movimento. Ogni libro deve essere catalogato, ogni pagina deve essere ritrovabile in frazioni di secondo, e l'intera struttura deve resistere a interruzioni di corrente, guasti hardware e persino agli errori umani. Questo è ciò che fa un file system: trasforma il caos binario in ordine comprensibile.

Ma come siamo arrivati qui? Come si è evoluto il modo in cui i computer organizzano i dati, dai primi floppy disk ai moderni data center che custodiscono petabyte di informazioni? Questa è la storia dei file system: un viaggio attraverso decenni di innovazione, fallimenti clamorosi, rivoluzioni silenziose e intuizioni geniali che hanno plasmato il mondo digitale come lo conosciamo.

1. Introduzione:

Perché Dovrebbe Importarti?

1.1 Il Contesto Storico

Per comprendere l'importanza dei file system, dobbiamo fare un passo indietro e osservare l'evoluzione dell'archiviazione digitale nel suo complesso.

Negli anni '50 e '60, i primi computer non avevano il lusso di dischi rigidi o memorie permanenti accessibili. I dati venivano inseriti tramite schede perforate e nastri magnetici, in un processo lento e laborioso. Non esisteva il concetto di "file" come lo intendiamo oggi: c'erano solo sequenze di dati da elaborare in modo sequenziale.

L'avvento dei dischi magnetici negli anni '60 cambiò tutto. Per la prima volta, era possibile accedere ai dati in modo casuale, saltando da una posizione all'altra del disco senza dover leggere tutto ciò che c'era prima. Ma questa nuova libertà portava con sé un problema: come organizzare questi dati in modo efficiente?

Nacquero così i primi file system, sistemi di organizzazione che dovevano risolvere problemi fondamentali:

Come sapere dove inizia e finisce un file?

Come trovare rapidamente un file tra migliaia?

Come gestire lo spazio libero sul disco?

Come proteggere i dati dalla corruzione?

1.2 Obiettivi dell'Analisi

Questo articolo si propone di esplorare l'evoluzione dei file system attraverso diverse prospettive:

Storica: Come siamo passati dai floppy disk ai sistemi enterprise moderni

Tecnica: I principi fondamentali che governano l'organizzazione dei dati

Pratica: Quale file system scegliere per ogni situazione

Prospettica: Dove sta andando l'innovazione in questo campo

Che tu sia un appassionato di tecnologia, un system administrator, o semplicemente qualcuno che vuole capire meglio cosa succede "sotto il cofano" del proprio computer, troverai in questo viaggio qualcosa di interessante.

1.3 Struttura dell'Articolo

L'analisi si articola in diverse sezioni:

Le origini: FAT e l'era dei floppy disk

La maturità: NTFS, ext e HFS+ negli anni 2000

La rivoluzione: ZFS e il nuovo paradigma dell'integrità dei dati

Il presente: exFAT, Btrfs, APFS e le soluzioni moderne

Guida pratica: Quale file system per quale situazione

Il futuro: Tendenze e innovazioni emergenti

2. Le Origini:

L'Era FAT e la Nascita dell'Organizzazione Digitale

2.1 Il Contesto: Quando i Computer Erano Dinosauri

Siamo alla fine degli anni '70. I personal computer stanno nascendo, ma sono macchine primitive per gli standard odierni. L'Apple II ha appena debuttato, l'IBM PC deve ancora arrivare, e la memoria si misura in kilobyte, non in gigabyte.

In questo scenario, Microsoft sta sviluppando un sistema operativo per i primi microcomputer. C'è un problema fondamentale da risolvere: come organizzare i dati sui floppy disk da 5,25 pollici che stanno diventando lo standard per la distribuzione del software?

La risposta fu il FAT (File Allocation Table), un sistema di organizzazione elegante nella sua semplicità.

2.2 FAT: L'Architettura di una Rivoluzione Silenziosa

Il nome stesso racconta la filosofia del sistema: al centro di tutto c'è una "tabella di allocazione dei file", una sorta di indice che tiene traccia di dove sono memorizzati i dati sul disco.

Immagina il disco come un grande quaderno a quadretti. Ogni quadretto (chiamato "cluster") può contenere una certa quantità di dati. La FAT è come un indice all'inizio del quaderno che dice: "Il file DOCUMENTO.TXT inizia al quadretto 15, continua al 16, poi salta al 45, e finisce al 46."

Questo sistema aveva diversi vantaggi per l'epoca:

Semplicità: Facile da implementare con le risorse hardware limitate del tempo

Efficienza: L'accesso casuale ai file era relativamente veloce

Compatibilità: Poteva funzionare su hardware molto diverso

Robustezza: Una copia di backup della FAT proteggeva dai guasti più comuni

2.3 L'Evoluzione della Specie FAT

Come ogni tecnologia di successo, FAT si è evoluto nel tempo per adattarsi a supporti sempre più capienti:

FAT12 (1977-1980)

La versione originale, progettata per i floppy disk. Il "12" indica che ogni entry nella tabella utilizzava 12 bit, permettendo di indirizzare fino a 4.096 cluster. Con cluster di dimensioni ragionevoli per l'epoca, questo era sufficiente per dischi fino a circa 16 MB.

Caratteristiche principali:

Progettato per floppy da 160 KB a 16 MB

Nomi file nel formato 8.3 (otto caratteri per il nome, tre per l'estensione)

Nessun supporto per permessi o attributi avanzati

Ancora oggi usato in alcune applicazioni embedded

FAT16 (1984-1987)

Con l'arrivo dei primi hard disk per personal computer, serviva un sistema che potesse gestire capacità maggiori. FAT16 estendeva la tabella a 16 bit per entry, permettendo fino a 65.536 cluster.

Caratteristiche principali:

Supporto per volumi fino a 2 GB (con cluster di 32 KB)

Ancora il formato 8.3 per i nomi dei file

Divenne lo standard per MS-DOS e le prime versioni di Windows

Problemi di efficienza con dischi grandi (cluster troppo grandi = spreco di spazio)

FAT32 (1996)

La vera rivoluzione arrivò con Windows 95 OSR2. FAT32 estendeva ulteriormente il sistema, permettendo di gestire dischi fino a 2 TB (teoricamente fino a 16 TB).

Caratteristiche principali:

Cluster più piccoli = meno spreco di spazio

Supporto per nomi file lunghi (fino a 255 caratteri)

Retrocompatibilità con il formato 8.3

Volume massimo: 2 TB (con settori da 512 byte)

Limite critico: file massimo di 4 GB

Quest'ultimo limite si sarebbe rivelato il tallone d'Achille di FAT32 nell'era moderna. Un singolo file non può superare i 4 GB, rendendo impossibile memorizzare film in alta definizione, immagini disco di DVD, o backup di grandi dimensioni.

2.4 FAT32: Il Cockroach dei File System

Nonostante i suoi limiti evidenti, FAT32 ha dimostrato una resilienza straordinaria. A quasi 30 anni dalla sua introduzione, rimane il file system più utilizzato al mondo per i supporti removibili.

Perché FAT32 sopravvive?

La risposta è una sola parola: compatibilità. FAT32 è supportato da praticamente ogni dispositivo che abbia mai visto la luce:

Ogni versione di Windows dal 1996

macOS (lettura e scrittura native)

Linux (supporto completo nel kernel)

Smart TV e lettori multimediali

Console di gioco (PlayStation, Xbox, Nintendo)

Autoradio e sistemi di infotainment

Fotocamere digitali

Router e NAS

Persino alcune stampanti e dispositivi medicali

Quando hai bisogno di trasferire file tra sistemi diversi senza problemi, FAT32 rimane spesso la scelta più sicura, purché nessun file superi i 4 GB.

2.5 I Limiti dell'Era FAT: Lezioni Apprese

L'architettura FAT, per quanto geniale per il suo tempo, portava con sé limitazioni strutturali che sarebbero diventate sempre più evidenti:

Assenza di journaling

Quando scrivi un file su un disco FAT, il sistema aggiorna prima i dati, poi la tabella di allocazione. Se il computer si spegne improvvisamente nel mezzo di questa operazione, puoi ritrovarti con:

File troncati o corrotti

Cluster marcati come "in uso" ma non associati a nessun file (cluster persi)

Catene di cluster interrotte

Chi ha vissuto l'era di Windows 98 ricorda bene il temuto "ScanDisk" all'avvio dopo uno spegnimento improvviso, spesso con risultati disastrosi per i dati.

Nessun sistema di permessi

FAT non ha il concetto di "proprietario" di un file o di permessi di accesso. Qualsiasi utente può leggere, modificare o cancellare qualsiasi file. Questo lo rende inadatto a qualsiasi ambiente multi-utente o dove la sicurezza sia importante.

Frammentazione

Quando crei, modifichi e cancelli file nel tempo, i dati tendono a disperdersi sul disco in frammenti non contigui. Questo rallenta significativamente l'accesso, specialmente sui dischi meccanici. La "deframmentazione" era un rituale periodico necessario per mantenere prestazioni accettabili.

Nessuna protezione dall'integrità

FAT non ha meccanismi per verificare che i dati siano stati scritti correttamente o per rilevare la corruzione silenziosa. Se un bit cambia a causa di un difetto del disco, il sistema non ha modo di accorgersene.

Queste limitazioni avrebbero spinto lo sviluppo di file system più sofisticati, progettati per un'era di computer sempre più potenti e esigenti.

3. L'Era della Maturità:

NTFS, ext e HFS+

3.1 NTFS: Microsoft Diventa Adulta

Con Windows NT nel 1993, Microsoft aveva ambizioni enterprise. Il pubblico target non erano più solo gli utenti domestici, ma aziende, server, workstation professionali. FAT era chiaramente inadeguato per questo mercato.

La risposta fu NTFS (New Technology File System), un file system completamente riprogettato da zero con obiettivi ambiziosi:

Architettura NTFS: Un Nuovo Paradigma

NTFS abbandona l'architettura semplice di FAT per un sistema molto più sofisticato, organizzato attorno al concetto di Master File Table (MFT).

La MFT è una sorta di database relazionale che contiene informazioni su ogni file e directory del volume:

Nome del file (supporto nativo Unicode)

Attributi (permessi, timestamp, flag)

Posizione dei dati sul disco

Per file piccoli (< ~900 byte), i dati stessi sono memorizzati direttamente nella MFT

Questo approccio offre diversi vantaggi:

Accesso rapidissimo ai metadati dei file

Flessibilità nel tipo di informazioni memorizzabili

Recupero più semplice in caso di corruzione

Journaling: L'Assicurazione contro i Disastri

La caratteristica più importante di NTFS è il journaling (o "registrazione delle transazioni"). Prima di eseguire qualsiasi modifica ai metadati del file system, NTFS scrive un "registro delle intenzioni" in un'area speciale del disco.

Il processo funziona così:

L'utente chiede di creare un nuovo file

NTFS scrive nel journal: "Sto per creare il file X nella directory Y"

NTFS esegue l'operazione

NTFS marca l'operazione nel journal come "completata"

Se il sistema si spegne improvvisamente durante il passo 3:

Al riavvio, NTFS legge il journal

Trova l'operazione non completata

Può annullarla (rollback) o completarla (replay)

Il file system rimane in uno stato coerente

Questo eliminava quasi completamente il problema della corruzione da spegnimento improvviso che affliggeva FAT.

Sicurezza Integrata: ACL e Permessi

NTFS introduce un sistema di permessi basato su Access Control Lists (ACL). Ogni file e directory può avere regole dettagliate su chi può:

Leggere il contenuto

Scrivere o modificare

Eseguire (per i programmi)

Cancellare

Modificare i permessi stessi

Prendere possesso dell'oggetto

I permessi possono essere assegnati a:

Singoli utenti

Gruppi di utenti

Entità speciali (come "Everyone" o "Administrators")

Questo sistema, ereditato dalla tradizione Unix ma implementato in modo indipendente, permetteva finalmente di usare Windows in ambienti multi-utente con vera separazione dei privilegi.

Funzionalità Avanzate

NTFS includeva fin dall'inizio funzionalità che altri file system avrebbero implementato solo anni dopo:

Compressione trasparente: I file possono essere compressi automaticamente, risparmiando spazio senza che le applicazioni debbano fare nulla di speciale.

Cifratura (EFS): I file possono essere cifrati con chiavi legate all'account utente. Se qualcuno ruba il disco, non può leggere i dati senza le credenziali corrette.

Hard link e junction point: Più "nomi" possono riferirsi allo stesso file, permettendo organizzazioni flessibili senza duplicare i dati.

Stream alternativi (ADS): Un file può contenere più "flussi" di dati. Questa funzionalità, poco conosciuta, è usata per memorizzare metadati aggiuntivi ma è stata anche sfruttata da malware per nascondere codice malevolo.

Quote disco: Gli amministratori possono limitare lo spazio utilizzabile da ciascun utente.

Limiti di NTFS

Nonostante i suoi pregi, NTFS ha alcune limitazioni:

Compatibilità cross-platform: macOS può leggere NTFS ma non scriverci nativamente. Linux richiede driver speciali (ntfs-3g) per la scrittura.

Overhead: Le funzionalità avanzate hanno un costo in termini di complessità e, in alcuni casi, prestazioni.

Frammentazione: Sebbene migliore di FAT, NTFS può comunque frammentarsi significativamente nel tempo.

Nessuna protezione dall'integrità dei dati: Come FAT, NTFS non ha checksum sui dati. La corruzione silenziosa non viene rilevata.

3.2 ext2, ext3, ext4: L'Evoluzione nel Mondo Linux

Mentre Microsoft sviluppava NTFS, il mondo Unix e poi Linux seguiva un percorso parallelo con la famiglia di file system ext (Extended File System).

ext2: Le Fondamenta (1993)

ext2 (second extended file system) divenne rapidamente lo standard per Linux. Progettato per essere veloce, affidabile e con un basso overhead, introduceva concetti fondamentali:

Inode: Ogni file è rappresentato da una struttura dati chiamata "inode" che contiene tutti i metadati e i puntatori ai blocchi di dati

Gruppi di blocchi: Il disco è diviso in gruppi, ognuno con la propria tabella di inode e bitmap di allocazione, migliorando la località dei dati

Permessi Unix: Il classico modello owner/group/others con permessi read/write/execute

ext2 era veloce e affidabile, ma aveva un problema cruciale: come FAT, non aveva journaling. Un crash poteva richiedere un lungo controllo di integrità (fsck) al riavvio.

ext3: L'Arrivo del Journal (2001)

ext3 aggiunse il journaling a ext2, mantenendo la piena retrocompatibilità. Un volume ext2 poteva essere "aggiornato" a ext3 semplicemente creando il file di journal, senza riformattare.

Tre modalità di journaling erano disponibili:

Journal: Sia metadati che dati vengono scritti nel journal prima di essere committati. Massima sicurezza, prestazioni ridotte.

Ordered (default): Solo i metadati vanno nel journal, ma i dati vengono scritti prima dei metadati. Buon compromesso.

Writeback: Solo i metadati nel journal, dati e metadati scritti in ordine qualsiasi. Prestazioni massime, minore sicurezza.

ext4: La Maturità (2008)

ext4 rappresenta l'evoluzione moderna della famiglia, con miglioramenti significativi:

Extent: Invece di elencare ogni blocco singolarmente, ext4 può descrivere range contigui di blocchi ("da blocco X a blocco Y"), riducendo drasticamente l'overhead per file grandi.

Allocazione ritardata: Il sistema aspetta il più possibile prima di allocare effettivamente lo spazio su disco, permettendo decisioni più intelligenti sulla posizione dei dati.

Checksum del journal: Il journal stesso è protetto da checksum, riducendo il rischio di corruzione.

Volumi fino a 1 EB (exabyte): Limiti praticamente illimitati per le esigenze attuali.

Timestamp in nanosecondi: Precisione molto maggiore per i timestamp dei file.

Oggi ext4 è il file system predefinito per la maggior parte delle distribuzioni Linux, usato da server enterprise, smartphone Android, e innumerevoli dispositivi embedded.

3.3 HFS e HFS+: Il Mondo Apple

Apple ha sempre seguito un percorso indipendente. Il Hierarchical File System (HFS) debuttò nel 1985 con il Macintosh, seguito da HFS+ nel 1998.

HFS+ introduceva:

Supporto Unicode per i nomi dei file

Journaling (aggiunto nel 2002 con Mac OS X 10.2.2)

File di dimensioni fino a 8 EB

Compressione trasparente

Hard link

La filosofia Apple era "elegante ma chiuso": HFS+ funzionava benissimo sui Mac, ma era poco documentato e difficile da supportare su altri sistemi operativi. Windows non poteva leggerlo senza software di terze parti, e il supporto Linux era limitato.

Nel 2017, Apple ha sostituito HFS+ con APFS (Apple File System), progettato specificamente per SSD e con funzionalità moderne come snapshot nativi, clonazione efficiente dei file, e crittografia integrata.

4. La Rivoluzione:

ZFS e il Nuovo Paradigma

4.1 Sun Microsystems e la Nascita di un Gigante

Nel 2005, mentre il mondo dell'informatica consumer si accontentava di NTFS e ext3, qualcosa di rivoluzionario stava nascendo nei laboratori di Sun Microsystems.

Sun era un'azienda con una storia leggendaria nell'informatica enterprise: creatrice di SPARC, Java, Solaris, e di innumerevoli innovazioni che avevano plasmato l'industria. I loro ingegneri si posero una domanda fondamentale: "E se riprogettassimo il concetto stesso di file system, senza i compromessi del passato?"

Il risultato fu ZFS (originariamente Zettabyte File System), presentato come parte di Solaris 10. Non era semplicemente un nuovo file system: era una rivoluzione filosofica nel modo di pensare all'archiviazione dei dati.

4.2 Il Problema che ZFS Risolve: Il Bit Rot

Prima di capire ZFS, dobbiamo capire un problema che pochi conoscono: la corruzione silenziosa dei dati (silent data corruption), a volte chiamata "bit rot".

I supporti di memorizzazione non sono perfetti. Nel tempo, i dati possono corrompersi per diverse ragioni:

Difetti fisici del supporto magnetico o delle celle flash

Raggi cosmici che alterano singoli bit

Bug nel firmware dei dischi

Errori nei controller RAID hardware

Problemi di cablaggio o alimentazione

Il problema insidioso è che i file system tradizionali non se ne accorgono. Quando leggi un file, il sistema non ha modo di verificare che i dati letti siano esattamente quelli che erano stati scritti. La corruzione può passare inosservata per anni, finché non provi ad aprire quel file di backup "sicuro" e lo trovi illeggibile.

Studi nel settore enterprise hanno dimostrato che la corruzione silenziosa è molto più comune di quanto si pensasse. Un famoso studio CERN del 2007 rilevò errori non rilevati in circa lo 0.5% dei file su sistemi di storage enterprise.

4.3 La Filosofia ZFS: Trust Nothing, Verify Everything

ZFS parte da un presupposto radicale: non fidarti di niente. Non del disco, non del controller, non del cavo, non della RAM. Ogni singolo blocco di dati deve essere verificabile.

Checksum End-to-End

Ogni blocco di dati in ZFS è accompagnato da un checksum (tipicamente SHA-256 o Fletcher-4). Ma ecco il genio: il checksum non è memorizzato insieme ai dati, bensì nel blocco padre che punta a quei dati.

Questo crea una struttura ad albero chiamata Merkle tree:

I blocchi di dati hanno il loro checksum nel blocco di puntatori

Quel blocco di puntatori ha il suo checksum nel livello superiore

E così via fino alla radice del file system (uberblock)

Quando leggi un file:

ZFS legge il blocco di dati

Calcola il checksum di ciò che ha letto

Confronta con il checksum memorizzato

Se non corrisponde, sa che c'è corruzione

E qui viene il bello: se hai ridondanza (mirror o RAID-Z), ZFS può automaticamente recuperare la copia corretta da un'altra posizione. Il tutto in modo trasparente, senza intervento umano.

Copy-on-Write: Mai Sovrascrivere

I file system tradizionali, quando modifichi un file, sovrascrivono i dati esistenti. Questo è pericoloso: se qualcosa va storto durante la scrittura, puoi perdere sia la vecchia che la nuova versione.

ZFS usa un approccio chiamato Copy-on-Write (CoW):

I nuovi dati vengono scritti in una nuova posizione sul disco

I metadati vengono aggiornati per puntare ai nuovi dati

Solo quando tutto è completato con successo, lo spazio vecchio viene liberato

Questo significa che il file system è sempre in uno stato coerente. Non c'è mai un momento in cui i dati sono "a metà": o hai la vecchia versione completa, o la nuova versione completa.

4.4 Pool Storage: Addio ai Volumi Tradizionali

Un'altra innovazione fondamentale di ZFS è il concetto di storage pool.

Nei file system tradizionali, ogni disco (o partizione) è un'entità separata. Se hai tre dischi da 1 TB, hai tre volumi separati da gestire. Vuoi espandere? Devi riformattare o usare complessi sistemi di volume management.

ZFS ribalta questo paradigma:

Tutti i dischi vengono aggiunti a un pool (zpool)

Il pool appare come un unico grande spazio di storage

Su questo pool puoi creare dataset (simili a directory, ma con proprietà configurabili indipendentemente)

Ogni dataset può avere quote, compressione, snapshot indipendenti

Vuoi aggiungere un disco? Lo aggiungi al pool e lo spazio diventa immediatamente disponibile. Vuoi sostituire un disco con uno più grande? ZFS può fare il "resilver" automaticamente, copiando i dati sul nuovo disco mentre il sistema continua a funzionare.

4.5 RAID-Z: RAID Senza Controller Hardware

ZFS include il proprio sistema di ridondanza chiamato RAID-Z, che offre diversi livelli:

RAID-Z1: Simile a RAID-5, tollera la perdita di un disco

RAID-Z2: Simile a RAID-6, tollera la perdita di due dischi

RAID-Z3: Tollera la perdita di tre dischi

Mirror: Due o più copie identiche dei dati

Ma RAID-Z ha vantaggi cruciali rispetto al RAID hardware tradizionale:

Write hole immunity: Il RAID-5 tradizionale ha un problema noto come "write hole": se il sistema crasha durante una scrittura, il RAID può trovarsi in uno stato incoerente. RAID-Z, grazie al copy-on-write, è immune a questo problema.

Self-healing: Quando ZFS rileva un blocco corrotto in un array RAID-Z, può ricostruirlo automaticamente dalla parità e riscrivere la copia corretta.

No controller proprietario: Non serve hardware costoso. ZFS gestisce tutto via software, e i dati sono leggibili su qualsiasi sistema che supporti ZFS.

4.6 Snapshot: La Macchina del Tempo

Una delle funzionalità più amate di ZFS sono gli snapshot: fotografie istantanee dello stato del file system.

Grazie al copy-on-write, creare uno snapshot è praticamente istantaneo e non occupa spazio aggiuntivo (inizialmente). Lo snapshot semplicemente "blocca" i puntatori attuali, impedendo che i blocchi vengano riutilizzati.

Man mano che i dati cambiano, lo snapshot mantiene i riferimenti ai vecchi blocchi. Occupi spazio extra solo per le differenze.

Applicazioni pratiche:

Backup incrementali: Puoi inviare solo le differenze tra due snapshot

Rollback: Hai fatto un errore? Torna a uno snapshot precedente in secondi

Clone: Crea una copia "virtuale" di un dataset che condivide i blocchi comuni

Test sicuri: Prova una modifica rischiosa, se va male fai rollback

4.7 ZFS in Pratica: Un Esempio Concreto

Immaginiamo uno scenario reale: un NAS domestico con quattro dischi da 4 TB.

Setup tradizionale (senza ZFS):

Compri un controller RAID hardware

Configuri RAID-5 (12 TB utili, protezione da 1 guasto)

Crei una partizione ext4 o NTFS

Speri che tutto funzioni

Setup con ZFS:

# Crea un pool con RAID-Z1 zpool create tank raidz1 sda sdb sdc sdd # Abilita compressione trasparente zfs set compression=lz4 tank # Crea dataset per diversi usi zfs create tank/media zfs create tank/backup zfs create tank/documents # Configura snapshot automatici giornalieri # (con uno scheduler come sanoid)

Da questo momento:

Ogni blocco scritto viene verificato con checksum

La corruzione viene rilevata e corretta automaticamente

Puoi tornare indietro nel tempo con gli snapshot

Se un disco si guasta, lo sostituisci e ZFS ricostruisce automaticamente

Se vuoi più spazio, puoi sostituire i dischi con modelli più grandi uno alla volta

4.8 Il Prezzo della Perfezione: Requisiti e Considerazioni

ZFS non è privo di svantaggi:

RAM: ZFS è noto per essere "affamato" di memoria. La regola empirica è 1 GB di RAM per ogni TB di storage, più RAM aggiuntiva se usi deduplicazione.

Licenza: ZFS è sotto licenza CDDL, incompatibile con la GPL di Linux. Questo ha portato a complicazioni legali e all'impossibilità di includere ZFS direttamente nel kernel Linux (anche se progetti come OpenZFS permettono di usarlo come modulo).

Complessità: ZFS ha molte opzioni e richiede comprensione per essere usato al meglio. Un errore di configurazione può costare caro.

Non si restringe facilmente: Puoi aggiungere dischi a un pool, ma rimuoverli è difficile o impossibile in alcune configurazioni.

Nonostante questi limiti, ZFS rimane la scelta preferita per chiunque prenda sul serio l'integrità dei propri dati: NAS, server di backup, storage enterprise, e sempre più anche homelab di appassionati.

5. Il Presente:

Il Panorama Moderno dei File System

5.1 exFAT: Il Compromesso Universale

Con il crescere delle dimensioni dei file multimediali, il limite di 4 GB di FAT32 divenne insostenibile. Microsoft rispose nel 2006 con exFAT (Extended FAT).

exFAT è progettato come il "FAT32 del 21° secolo":

Limite teorico di 16 EB per singolo file

Volume massimo di 128 PB

Nomi file fino a 255 caratteri Unicode

Struttura semplice e veloce

Ma la vera forza di exFAT è la compatibilità:

Windows (da XP SP2 in poi)

macOS (da 10.6.5)

Linux (supporto nel kernel dal 2019)

PlayStation, Xbox, Nintendo Switch

Smart TV, fotocamere, action camera

La maggior parte dei dispositivi moderni

exFAT è diventato lo standard de facto per:

Schede SD di capacità superiore a 32 GB (SDXC)

Chiavette USB per file grandi

Hard disk esterni per uso cross-platform

Non ha journaling né protezione avanzata, ma per supporti removibili usati per trasferire file tra sistemi diversi, rimane la scelta migliore.

5.2 Btrfs: Lo ZFS di Linux?

Btrfs (B-tree File System, pronunciato "Butter FS") nasce nel 2007 come tentativo di portare le funzionalità di ZFS nel mondo Linux, ma con licenza GPL.

Condivide molti concetti con ZFS:

Copy-on-write

Checksum dei dati e dei metadati

Snapshot e cloni

RAID integrato (RAID 0, 1, 10, 5, 6)

Compressione trasparente

Gestione del volume integrata

Btrfs è il file system predefinito su alcune distribuzioni (come openSUSE e Fedora) e sui NAS Synology. È particolarmente apprezzato per:

Snapshot facili e veloci

Bilanciamento automatico dello spazio

Possibilità di aggiungere e rimuovere dischi dinamicamente

Conversione da ext4 senza riformattare

Tuttavia, Btrfs ha avuto una storia travagliata:

RAID 5/6 sono stati a lungo considerati instabili (la situazione sta migliorando)

Prestazioni variabili in alcuni carichi di lavoro

Meno maturo di ZFS per storage enterprise critico

Per uso desktop e NAS domestico, Btrfs è un'ottima scelta. Per storage enterprise mission-critical, molti preferiscono ancora ZFS.

5.3 APFS: Apple Guarda al Futuro

Nel 2017, Apple ha introdotto APFS (Apple File System), progettato da zero per le esigenze moderne:

Ottimizzato per SSD: APFS è progettato pensando alla flash NAND, con comandi TRIM nativi e minimizzazione delle scritture.

Crittografia nativa: La cifratura è integrata nel file system, non un layer aggiuntivo. Può cifrare singoli file, intere partizioni, o usare chiavi multiple per diversi dati.

Space sharing: Più volumi possono condividere lo stesso pool di storage, allocando dinamicamente lo spazio secondo necessità.

Snapshot e cloni: Come ZFS e Btrfs, APFS supporta snapshot istantanei e cloni efficienti.

Timestamp in nanosecondi: Precisione molto maggiore per i timestamp, importante per build system e sincronizzazione.

Copy-on-write per i file: La copia di un file non duplica fisicamente i dati, ma crea riferimenti agli stessi blocchi.

APFS è ora lo standard per tutti i dispositivi Apple: Mac, iPhone, iPad, Apple Watch, Apple TV. È un file system moderno e capace, anche se—fedele alla tradizione Apple—completamente chiuso e difficile da supportare su altre piattaforme.

5.4 ReFS: Microsoft Risponde (Sort of)

Microsoft ha tentato la sua risposta a ZFS con ReFS (Resilient File System), introdotto con Windows Server 2012.

ReFS include:

Checksum per i metadati (opzionalmente per i dati)

Correzione automatica degli errori con Storage Spaces

Nessuna limitazione pratica di dimensioni

Integrazione con Storage Spaces per ridondanza

Tuttavia, ReFS ha avuto un'adozione limitata:

Non può essere usato come disco di boot (!)

Mancano funzionalità come compressione e deduplicazione in alcune versioni

Non supporta tutte le funzionalità di NTFS

Microsoft ha limitato la sua disponibilità alle edizioni Pro/Enterprise/Server

ReFS è usato principalmente in ambito enterprise con Windows Server, ma non ha avuto l'impatto rivoluzionario di ZFS.

6. Guida Pratica:

Quale File System per Quale Situazione

6.1 Tabella di Riferimento Rapido

SituazioneFile System ConsigliatoAlternativaNoteChiavetta USB multipiattaformaexFATFAT32 (se < 4GB per file)Massima compatibilitàDisco di sistema WindowsNTFS-ObbligatorioDisco di sistema macOSAPFS-Default dal 2017Disco di sistema Linuxext4Btrfs, XFSext4 per semplicitàServer Linux / NASZFSext4, BtrfsZFS per integritàStorage enterprise con WindowsReFSNTFSCon Storage SpacesBackup critici con ridondanzaZFSBtrfsSelf-healingScheda SD per fotocameraFAT32 o exFAT-Controllare manualeSSD esterno per MacAPFSexFAT (cross-platform)APFS se solo MacArchivio a lungo termineZFS-Integrità verificabileGaming consoleexFATFAT32Verificare compatibilitàCondivisione in rete (SMB)Qualsiasi supportato-Il protocollo astrae il FS

6.2 Scenario 1: L'Utente Domestico

Profilo: Usa Windows e macOS, vuole scambiare file facilmente, salva foto, video, documenti.

Raccomandazione:

Dischi interni Windows: NTFS (già configurato)

Dischi interni Mac: APFS (già configurato)

Hard disk esterno di backup: exFAT (compatibile con entrambi)

Chiavette USB: exFAT (o FAT32 se servono dispositivi vecchi)

Consiglio bonus: Per backup importanti, considera un NAS con ZFS o Btrfs. I dati che tieni su un singolo disco senza ridondanza non sono veramente al sicuro.

6.3 Scenario 2: Il Creativo / Video Editor

Profilo: Lavora con file enormi (video 4K/8K, progetti Premiere/DaVinci), ha bisogno di prestazioni e affidabilità.

Raccomandazione:

SSD di lavoro: APFS (Mac) o NTFS (Windows) - velocità massima

Storage di progetto (esterno): exFAT se cross-platform, altrimenti nativo del sistema

Archivio completato: ZFS su NAS con snapshot

Consiglio bonus: Usa la regola 3-2-1 per i backup: 3 copie dei dati, su 2 tipi di supporto diversi, con 1 copia offsite. Per i video raw che non puoi ricreare, ZFS con checksum è l'unico modo per dormire sonni tranquilli.

6.4 Scenario 3: L'Homelab Enthusiast

Profilo: Sperimenta con server, VM, container, vuole imparare ma anche proteggere i dati.

Raccomandazione:

Boot drive Proxmox/TrueNAS: ext4 o ZFS

Storage VM/dati: ZFS (preferibile) o Btrfs

Setup consigliato: Pool ZFS con RAID-Z1 (minimo 3 dischi) o mirror (2 dischi)

Esempio pratico:

# Su TrueNAS SCALE o Proxmox # Pool per VM con due dischi in mirror zpool create vmpool mirror /dev/sda /dev/sdb # Pool per storage con quattro dischi in RAID-Z1 zpool create datapool raidz1 /dev/sdc /dev/sdd /dev/sde /dev/sdf # Abilita compressione zfs set compression=lz4 datapool # Crea dataset con snapshot automatici zfs create datapool/media zfs create datapool/backup zfs create datapool/documents

6.5 Scenario 4: Il System Administrator Enterprise

Profilo: Gestisce server di produzione, SLA stringenti, dati business-critical.

Raccomandazione:

Server Linux: ext4 per semplicità, ZFS/XFS per storage pesante

Server Windows: NTFS (boot), ReFS con Storage Spaces (storage)

Database ad alte prestazioni: XFS o ext4 (journaling appropriato)

Storage di backup: ZFS con replica remota

Considerazioni:

Per Oracle: spesso raccomandano ASM o file system specifici

Per VMware: VMFS o vSAN

Verifica sempre le raccomandazioni del vendor per il software in uso

7. Il Futuro:

Tendenze e Innovazioni

7.1 Computational Storage

Una tendenza emergente è lo spostamento di alcune operazioni dal sistema operativo direttamente nel dispositivo di storage. Gli SSD "computazionali" possono eseguire operazioni come:

Compressione/decompressione

Cifratura/decifratura

Ricerca e indicizzazione

Operazioni su database

Questo richiederà file system che possano delegare intelligentemente le operazioni al dispositivo.

7.2 Storage Persistente Non-Volatile

Tecnologie come Intel Optane (ora discontinuata) e future memorie persistenti sfumano il confine tra storage e RAM. File system come NOVA e PMFS sono progettati specificamente per questi nuovi paradigmi, dove l'accesso ai dati persistenti può essere veloce quasi quanto l'accesso alla RAM.

7.3 File System Distribuiti

Con il cloud computing, sempre più storage è distribuito su più macchine fisiche. File system come:

Ceph: Storage distribuito open source

GlusterFS: File system scalabile

HDFS: Per big data (Hadoop)

S3: Object storage (non propriamente un file system)

stanno diventando sempre più importanti per scale massicce.

7.4 Integrità come Standard

La lezione di ZFS sta permeando l'intera industria. Sempre più file system implementano checksum e verifiche di integrità. È possibile che in futuro l'integrità verificabile diventi una caratteristica standard, non un'eccezione.

8. Conclusione:

Non Sottovalutare Mai i Fondamenti

8.1 Lezioni Apprese

Questo viaggio attraverso la storia dei file system ci insegna diverse lezioni:

La semplicità ha un costo: FAT32 sopravvive per la sua semplicità, ma paga con limitazioni che nel 2024 sembrano anacronistiche. A volte il "funziona ovunque" vale più della perfezione tecnica.

L'integrità dei dati non è scontata: Per decenni abbiamo costruito sistemi di storage che non potevano verificare se i dati fossero corrotti. ZFS ha dimostrato che si può fare meglio, e questa lezione sta influenzando l'intera industria.

L'evoluzione è continua: Dai floppy disk agli SSD NVMe, dai KB ai PB, i file system si sono evoluti costantemente per adattarsi a nuove tecnologie e nuove esigenze. Questa evoluzione continuerà.

La scelta giusta dipende dal contesto: Non esiste un file system "migliore" in assoluto. La scelta dipende dalle tue esigenze specifiche: compatibilità, prestazioni, affidabilità, semplicità.

8.2 Il Valore dell'Invisibile

I file system sono l'epitome della tecnologia invisibile: quando funzionano, non li noti. Ma la prossima volta che salvi un documento, copi una foto, o fai il backup dei tuoi dati, pensa per un momento al sistema complesso che sta lavorando sotto il cofano.

Ogni file che hai mai salvato, ogni foto delle vacanze, ogni documento di lavoro, ogni progetto creativo—tutto esiste grazie a queste strutture dati eleganti che organizzano il caos binario in informazione utilizzabile.

E quando scegli come formattare quel nuovo disco esterno, o come configurare il tuo NAS, ricorda: quella scelta potrebbe fare la differenza tra "ho perso tutto" e "il sistema ha recuperato automaticamente".

Scegli con saggezza. I tuoi dati te ne saranno grati.

Bibliografia: