Virtual Machine o Container? (Part.2)

In ogni sala server del mondo, una domanda aleggia nell'aria condizionata: Virtual Machine o Container? È come scegliere tra un solido SUV e una sportiva agile — entrambi vi porteranno a destinazione, ma in modi profondamente diversi. In ogni sala server del mondo, una domanda aleggia nell'aria condizionata: Virtual Machine o Container? È come scegliere tra un solido SUV e una sportiva agile — entrambi vi porteranno a destinazione, ma in modi profondamente diversi. L'ATTESA PARTE 2

RETI E INFRASTRUTTURE DIGITALIINNOVAZIONE E TECNOLOGIE EMERGENTIIN PRIMA PAGINA

La Danza dei Sistemi

Quando e Come Scegliere tra VM e Container

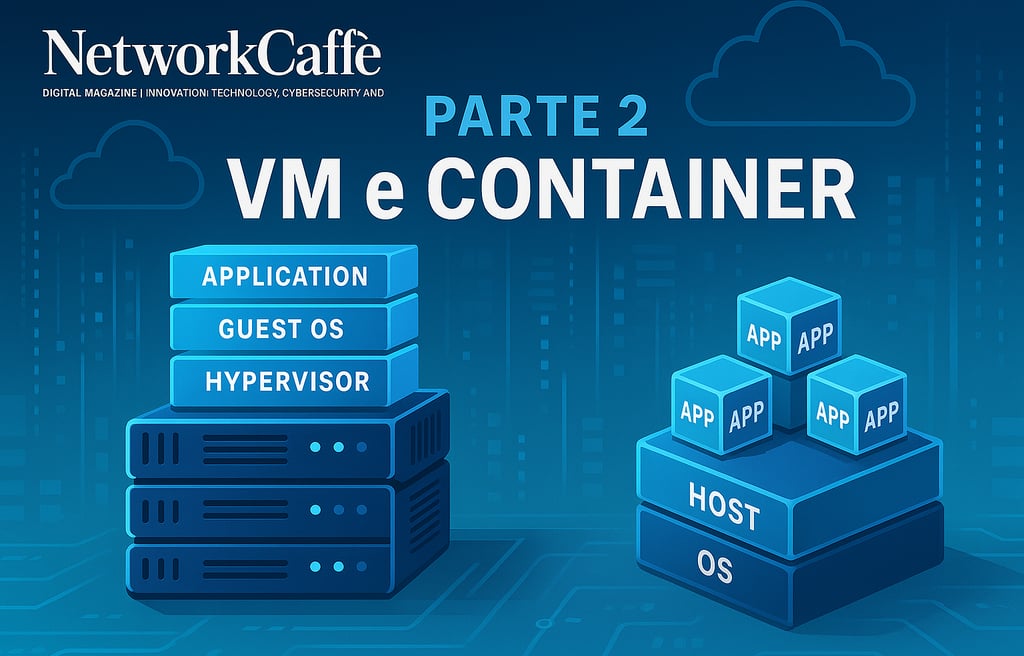

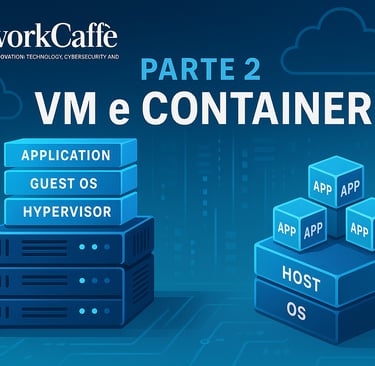

7. Duello tecnologico: VM vs Container nell'arena Enterprise

In ogni sala server del mondo, una domanda aleggia nell'aria condizionata: Virtual Machine o Container? È come scegliere tra un solido SUV e una sportiva agile — entrambi vi porteranno a destinazione, ma in modi profondamente diversi.

Il dilemma non ammette risposte universali, ma offre scenari ben definiti che guidano questa scelta strategica. Nelle grandi organizzazioni moderne, queste tecnologie spesso co-esistono pacificamente, come quartieri diversi di una metropoli in evoluzione, ciascuno con carattere e funzione propri. Esploriamo quando è meglio optare per l'una o l'altra soluzione.

7.1. Quando le Virtual Machine Prendono il Comando

Applicazioni legacy: quando il passato esige rispetto Quel vostro ERP degli anni '90 o quell'applicazione Windows scritta in .NET Framework classico non sono nati per nuotare nell'oceano dei container. Questi software, come anziani cittadini abituati alla propria dimora, necessitano di un ambiente familiare. La virtualizzazione tradizionale offre esattamente questo: una replica fedele dell'ambiente server classico, garantendo una compatibilità senza compromessi e un isolamento rassicurante. Quando l'applicazione richiede dipendenze kernel specifiche, driver proprietari o un'interfaccia grafica locale, o semplicemente non comprende l'architettura "stateless", una VM dedicata diventa non solo la soluzione più semplice, ma talvolta l'unica percorribile.

Diversità di sistemi operativi: la torre di Babele digitale Quando la vostra organizzazione deve orchestrare un concerto tra diversi sistemi operativi (Windows, Linux, BSD...), le VM sono come traduttori universali. A differenza dei container, che parlano una sola lingua nativa (un container Linux non dialogherà mai naturalmente con Windows), un hypervisor è poliglotta per design. Su un singolo host fisico potete creare isole Windows, Linux, BSD che convivono in perfetta armonia, ciascuna con il proprio dialetto digitale.

Isolamento categorico: fortezze in un mondo ostile In ambienti con clienti esterni o team interni di cui non ci si fida completamente, l'isolamento diventa priorità assoluta, come una cassaforte bancaria. Le VM offrono perimetri di sicurezza rigidi: un exploit nel sistema operativo ospitato raramente contaminerà l'host. Nei container, invece, una vulnerabilità del kernel condiviso potrebbe potenzialmente aprire una breccia nell'intero ecosistema. Quando la sicurezza non ammette compromessi, le VM costruiscono muri più spessi.

Workload affamati: quando le risorse non si condividono Certi software, come database enterprise o elaborazioni scientifiche ad alta intensità, sono come atleti professionisti: richiedono un ambiente dedicato, ottimizzato per le loro esigenze specifiche. Sebbene esistano container privilegiati o isolati in mini-VM (Hyper-V isolation, Kata Containers), quando un carico di lavoro critico esige garanzie categoriche di risorse, la VM rimane l'approccio consolidato, collaudato da anni di esperienza sul campo.

Il supporto del vendor: quando il manuale dice "VM" Alcuni produttori (Oracle, SAP, ERP proprietari) possono rispondere "Non supportato" se il loro prodotto gira in un container. Le linee guida di supporto spesso citano esplicitamente "OS ufficiale in VM o bare metal" come unico scenario certificato. Quando la compliance con questi contratti è imprescindibile, restare su VM diventa una necessità, non una scelta.

Compliance e auditing: quando il regolatore vuole certezze Gli standard di sicurezza come PCI-DSS o HIPAA hanno procedure consolidate per l'ambiente VM, mentre i container richiedono interpretazioni più creative o controlli aggiuntivi. Anche la gestione dei log di audit e le scansioni antivirus seguono percorsi ben definiti in VM, dove è possibile installare agenti tradizionali. Nel cosmo dei container servono strumenti differenti, a volte ancora in fase di maturazione.

Infrastruttura esistente: quando il passato pesa sul futuro Se la vostra azienda ha investito significativamente in piattaforme come VMware vSphere, con licenze pluriennali, storage integrato (vSAN), backup (Veeam) e personale formato, il salto verso i container potrebbe sembrare un tuffo nel vuoto. La migrazione richiede nuove competenze (Docker, Kubernetes, CI/CD) e un cambio culturale (DevOps). Quando i vantaggi del cambiamento non sono cristallini, preservare lo status quo su VM può essere la via più prudente, specialmente per applicazioni stabili che non cambiano frequentemente.

7.2. Quando i Container Prendono il Volo

Microservizi e cloud-native: l'arte del dividi et impera Le architetture a microservizi (12-factor apps), protagoniste indiscusse del mondo web e mobile, trovano nei container il loro habitat naturale. Questa simbiosi permette una scalabilità orizzontale elettrizzante: ogni microservizio diventa un blocco Lego che può essere replicato come container in pochi secondi, orchestrato elegantemente da Kubernetes o piattaforme simili. I container non solo ospitano questi microservizi, ma ne amplificano i vantaggi intrinseci.

CI/CD e test: laboratori volatili perfetti Nei flussi DevOps, i container sono come camici da laboratorio usa e getta: rendono semplicissimo creare e distruggere ambienti isolati per test di integrazione o scenari QA, assicurando coerenza assoluta con la produzione. "Funziona in un container" significa eliminare alla radice le sorprese dovute a differenze ambientali tra lo sviluppo locale e i server di produzione, quel "ma sul mio computer funzionava!" che tormenta gli sviluppatori da generazioni.

Densità ed efficienza: l'arte della compressione digitale Quando dovete orchestrare decine o centinaia di istanze di piccoli servizi, i container brillano di luce propria: straordinariamente più leggeri in termini di RAM e CPU rispetto alle VM. Un server con 32 GB di RAM potrebbe ospitare comodamente 50 container Node.js, mentre faticherebbe a sostenere 5-6 VM complete con tutti i relativi servizi. È come confrontare una biblioteca digitale con una fisica: a parità di contenuti, la prima occupa una frazione dello spazio.

Scalabilità orizzontale immediata: elasticità in tempo reale Durante picchi di carico improvvisi (e-commerce sotto le festività, servizi web virali), lanciare nuovi container richiede pochi secondi, mentre avviare VM fresche richiederebbe minuti preziosi. In contesti "autoscaling cloud" (AWS, Azure), i container sono diventati lo standard de facto per respirare al ritmo frenetico della domanda, espandendosi e contraendosi quasi istantaneamente.

Portabilità multi-cloud: viaggiare leggeri Un container Docker è come un passaporto universale: la stessa immagine funzionerà indistintamente su un laptop, su un server aziendale, su una VM in cloud. Questa portabilità eccezionale favorisce strategie multi-cloud agili (potete migrare con disinvoltura le applicazioni containerizzate da un cloud all'altro, con l'unico vincolo di un runtime compatibile, come Docker o containerd).

Aggiornamenti frequenti: il cambio di abito senza interruzioni Se un'applicazione richiede rilasci frequenti, i container permettono rolling update e rollback quasi istantanei, come cambiare le ruote a un'auto in corsa. Gli orchestratori (Kubernetes, Docker Swarm) orchestrano una danza perfetta: avviando gradualmente nuovi container con la versione 2.0 mentre spengono quelli con la versione 1.9, senza che l'utente percepisca la minima interruzione.

Servizi effimeri: quando il temporaneo è virtù Ambienti di sviluppo per nuovi programmatori, test su librerie sperimentali, analisi batch di breve durata: scenari in cui i container brillano come fuochi d'artificio. Evitate il peso di provisioning VM e l'overhead di sistemi operativi completi, creando container che vivono solo il tempo necessario per completare il loro compito, per poi dissolversi senza lasciare traccia.

7.3. Terra di Confine: Quando le Scelte non sono Binarie

I database: il dilemma della persistenza Alcuni database relazionali (Oracle, MS SQL, PostgreSQL) possono tecnicamente girare in container, ma molte organizzazioni preferiscono il comfort di una VM dedicata, per gestire memoria e storage con mano ferma. D'altro canto, con database "cloud-native" (MongoDB, Cassandra) spesso troviamo "operator" Kubernetes dedicati che gestiscono il clustering in container con sorprendente efficacia. La scelta dipende dal database specifico e dalla maturità del team operativo.

Applicazioni Microsoft .NET: la metamorfosi in corso Con l'avvento di .NET Core, molte applicazioni .NET possono prosperare in container Linux o Windows. Se un'azienda gestisce un parco applicativo legacy su .NET Framework 4.x, containerizzarlo è possibile (in Windows containers) ma più complesso. La decisione si basa sulla facilità di reingegnerizzazione e sulla visione strategica: mantenere tutto su VM Windows o abbracciare il nuovo paradigma?

VDI (Virtual Desktop Infrastructure): desktop virtuali Le soluzioni VDI (VMware Horizon, Citrix Virtual Apps & Desktops, Microsoft RDS) richiedono generalmente VM Windows con capacità grafiche. È un territorio in cui i container raramente si avventurano. Esistono container che incapsulano singole applicazioni GUI, ma per desktop completi, l'hypervisor classico o le sessioni RDS rimangono le soluzioni predilette, come un vestito su misura rispetto a un capo prêt-à-porter.

Monoliti con appendici containerizzate: l'ibrido evolutivo Un'organizzazione potrebbe mantenere il nucleo applicativo su VM, sviluppando paralelamente nuove API o microservizi containerizzati che si integrano con il sistema esistente. Questo "approccio ibrido" è la firma delle trasformazioni digitali graduali: una parte del monolite persiste in VM, mentre nuovi componenti nascono già in container.

Coesistenza strategica: il meglio di entrambi i mondi Uno scenario sempre più frequente: l'organizzazione mantiene un cluster VMware/Proxmox con un pool di host fisici. Su alcune VM strategiche opera Kubernetes, che a sua volta orchestra container. Così si combinano i vantaggi delle VM (alta disponibilità infrastrutturale, sicurezza perimetrale) con quelli dei container (agilità e deployment rapido).

7.4. Case Studies: Quando la Teoria Incontra la Pratica

Banca Alfa: conservazione e innovazione in equilibrio Il core banking rimane ancorato a mainframe e VMware: non convertito a container per rigorosi vincoli di compliance e stabilità assoluta. Parallelamente, il nuovo servizio di mobile banking palpita con microservizi e Docker su cluster Kubernetes: rilasci continui, autoscaling adattivo in base al carico. Il risultato? Un'architettura bifronte: massima agilità per la parte digitale esterna, solidità e approccio conservativo per il nucleo transazionale legacy. Come una vettura ibrida, ciascun motore fa ciò che sa fare meglio.

E-commerce Beta: elasticità stagionale Operava con un datacenter interamente VMware, ma necessitava di scalare rapidamente durante eventi come il Black Friday. Ha introdotto Docker su AWS (ECS e successivamente EKS) per il front-end web e alcuni microservizi strategici, mantenendo in VMware i sistemi gestionali interni. Oggi sincronizza i dati tra i due ambienti, ottimizzando i costi in bassa stagione (contraendo i container in cloud) e preservando un'infrastruttura proprietaria per i servizi essenziali. La flessibilità economica diventa vantaggio competitivo.

Software house Gamma: adattabilità al cliente Ha adottato i container in Development/QA per test rapidi e ripetibili. In produzione, alcuni clienti conservatori richiedono macchine Windows + SQL Server in VM, altri abbracciano container Linux su cloud. La soluzione: pipeline CI/CD con script che generano sia immagini Docker sia template VM, offrendo flessibilità completa al cliente finale. L'adattabilità diventa il loro marchio di fabbrica.

8. L'Arte della Resilienza: Scalabilità e Alta Disponibilità

Uno dei motivi fondamentali per adottare virtualizzazione e container è costruire infrastrutture che crescano con le esigenze e sopravvivano ai guasti. Come Fenici digitali, capaci di rinascere dalle proprie ceneri.

8.1. Scalabilità nelle Cattedrali Virtuali

Cluster e Host: l'Unione Fa la Forza

In ecosistemi come VMware, Hyper-V o KVM, i server fisici si fondono in cluster organici. L'amministratore può espandere questo organismo aggiungendo nuovi nodi, aumentando la capacità complessiva in termini di CPU/RAM.

Le VM si distribuiscono sui nodi come abitanti di una città, e possono "migrare" per ottimizzare il bilanciamento del carico.

VMware: l'Orchestra Automatizzata

DRS (Distributed Resource Scheduler): direttore d'orchestra automatico che ridistribuisce le VM tra gli host disponibili, valutando metriche di utilizzo in tempo reale. Quando un host soffre sotto il carico, DRS trasferisce delicatamente alcune VM (live migration) verso nodi meno stressati.

HA (High Availability): sentinella vigile che, se un host fisico collassa, riavvia le VM orfane sugli altri nodi. Questo comporta un breve riavvio del sistema operativo, con qualche minuto di interruzione, ma l'applicazione non resta mai permanentemente offline.

Hyper-V: Il Guardiano Microsoft

Hyper-V organizzato in Failover Cluster monitora costantemente lo stato dei nodi. Se uno soccombe, le VM vengono immediatamente riassegnate.

Microsoft propone anche "Replica" (replicazione asincrona delle VM su siti alternativi) per scenari di Disaster Recovery più complessi.

L'Alternativa Open Source

In Proxmox, configurando un cluster con repository di storage condiviso (come Ceph), l'alta disponibilità diventa realtà. In caso di malfunzionamento di un nodo, le VM contrassegnate come critiche rinascono automaticamente su altri nodi.

L'equivalente della vMotion è la live migration basata su QEMU/KVM, a condizione che i dischi siano accessibili da tutti i nodi.

Due Filosofie di Crescita

Con le VM, spesso si "scala verticalmente", assegnando più risorse (vCPU, RAM) a una singola macchina. In alternativa, si clonano nuove VM identiche dietro un bilanciatore (scalabilità orizzontale).

I meccanismi di auto-scaling per VM on-premises sono rari, poiché lanciare VM supplementari richiede pianificazione, e gli strumenti di orchestrazione (vRealize Automation, SCVMM) possono risultare complessi da configurare e mantenere.

8.2. Scalabilità nell'Universo Container

Kubernetes: il Direttore d'Orchestra Definitivo

I container vengono quasi sempre orchestrati con strumenti come Kubernetes, Docker Swarm o Red Hat OpenShift, veri e propri sistemi nervosi digitali.

Kubernetes organizza i nodi in un cluster intelligente: se un container si arresta inaspettatamente, Kubernetes lo riavvia; se un intero nodo cade, Kubernetes ridistribuisce i "Pod" su altre macchine, come un generale che riposiziona rapidamente le truppe.

Scalabilità Orizzontale Intelligente

Il Horizontal Pod Autoscaler (HPA) di Kubernetes può aumentare o diminuire dinamicamente il numero di repliche di un servizio basandosi su metriche in tempo reale (CPU, RAM o parametri personalizzati).

Avviare nuovi container richiede pochi secondi se l'immagine è già presente sui nodi, rendendo la gestione dei picchi temporanei quasi istantanea.

Alta Disponibilità Intrinseca

Invece di riavviare la stessa VM su un altro host (approccio tradizionale), nei container si mantengono più repliche simultaneamente attive. Se una replica si blocca, le altre continuano a servire richieste senza interruzione, mentre l'orchestratore ne avvia silenziosamente una nuova.

Questo modello di "ridondanza attiva" permette tempi di auto-guarigione (self-healing) misurabili in secondi, non in minuti.

Recupero Fulmineo

L'avvio di un container richiede spesso meno di un secondo (dipende dall'applicazione). Di conseguenza, l'alta disponibilità diventa quasi impercettibile: invece di affrontare un downtime per riavviare un intero sistema operativo, l'orchestratore genera un container sostitutivo su un altro nodo.

Aggiornamenti Senza Interruzioni

Kubernetes e piattaforme simili permettono di aggiornare i container uno alla volta, mantenendo il servizio costantemente disponibile. In caso di problemi, il rollback all'immagine precedente avviene con la stessa fluidità.

Nelle VM si possono implementare aggiornamenti "in-place" con snapshot, ma gestire rilasci continui su larga scala diventa un'impresa logistica complessa.

8.3. Confronto Temporale: la Velocità è Tutto

Lo Scenario del Picco Improvviso

Quando un sito e-commerce subisce un'impennata di traffico non prevista, con architetture VM sarebbe necessario "accendere" macchine supplementari, attendere minuti preziosi per il boot, e configurare manualmente il bilanciatore.

Con container e Kubernetes HPA, l'espansione avviene quasi automaticamente: "Aggiungi 5 container" diventa realtà in pochi secondi, mentre l'infrastruttura si adatta al nuovo carico come un organismo vivente.

I Limiti Fisici Rimangono

Naturalmente, anche i container sottostanno alle leggi della fisica: se tutti i nodi del cluster raggiungono la saturazione, sarà necessario aggiungere nuovo hardware o VM in cloud.

Ma il deployment di nuovi container risulta generalmente più rapido e flessibile, specialmente in un cluster già dimensionato con margini adeguati di sicurezza.

8.4. Alta Disponibilità e Fault Tolerance: Strategie di Sopravvivenza

Approccio HA nei Cluster VMware

Se un host fisico si disconnette, entro 1-2 minuti le VM vengono identificate come offline e riavviate su altri nodi. Questo comporta una breve interruzione (il tempo di riavvio dell'OS guest).

Con VMware Fault Tolerance (FT) è possibile mantenere una VM gemella in sincronizzazione costante con la macchina primaria. Se l'host principale fallisce, la VM shadow subentra istantaneamente. Tuttavia, FT introduce overhead significativi e non è sempre applicabile.

Alta Disponibilità in Kubernetes

Kubernetes mantiene strategicamente N repliche in parallelo. La perdita di un container (o di un intero nodo) non compromette il servizio, poiché le altre repliche continuano a operare senza interruzioni.

Il concetto di "riavvio su nodo alternativo" è completamente automatizzato, e i container si rigenerano in pochi secondi, riducendo drasticamente l'impatto percepito.

Disaster Recovery: Pianificare l'Impensabile

Nelle architetture VM, tipicamente si implementa la replica dello storage e la configurazione del cluster in un sito secondario (DR). In caso di disastro, si "risvegliano" le VM replicate.

Con i container, si possono replicare i dati su storage distribuiti (Ceph, Gluster, EBS multi-AZ in cloud) e mantenere le definizioni Kubernetes in repository Git. Il ripristino avviene ricreando il cluster in una location alternativa e montando lo storage replicato.

In pratica, il DR containerizzato richiede un'impostazione "cloud-native" (dove ogni elemento di configurazione è definibile come codice), ma offre ripristini potenzialmente più rapidi e flessibili.

Riassumendo: la virtualizzazione tradizionale fornisce alta disponibilità a livello infrastrutturale (riavvio delle VM se l'host cade), mentre i container adottano un modello di ridondanza attiva a livello applicativo (più istanze parallele). Nel primo caso, se una VM si arresta c'è un riavvio (con breve downtime); nel secondo caso (container), la perdita di un'istanza passa inosservata, a condizione che l'applicazione sia progettata secondo i principi di resilienza distribuita.

9. L'Equazione Economica: Oltre il Prezzo delle Licenze

Nella battaglia tra VM e container, il budget è spesso il fattore decisivo. Tuttavia, il vero costo va ben oltre il prezzo delle licenze: come un iceberg, nasconde sotto la superficie i costi hardware, le competenze necessarie e la manutenzione quotidiana.

9.1. La Geometria Variabile delle Licenze

VMware vSphere:

il Leader con Prezzo Premium

Licenza calcolata "per socket" o "per CPU", con edizioni progressive (Standard, Enterprise, Enterprise Plus), ciascuna con funzionalità e costi crescenti. L'Enterprise Plus, comprensiva di DRS e vMotion illimitato, può costare migliaia di euro per socket. Vanno considerati anche vCenter e i costi di supporto annuale (SnS). L'acquisizione da parte di Broadcom (2023) ha portato aumenti di listino e incertezze strategiche, spingendo alcune organizzazioni verso alternative open source.

Microsoft Hyper-V:

la Strategia dell'Ecosistema

Integrato in Windows Server, con licenze Windows Server Datacenter che permettono teoricamente VM Windows illimitate sullo stesso host. Hyper-V Server "gratuito" è stato abbandonato dopo Windows Server 2019, indirizzando i clienti verso Azure Stack HCI. Risulta più conveniente in ambienti Windows-centrici, ma per ecosistemi multi-OS le funzionalità rimangono paragonabili con penetrazione di mercato inferiore.

KVM:

il Potere dell'Open Source

Completamente open source e integrato nel kernel Linux, senza costi di licenza diretti. Le organizzazioni possono optare per distribuzioni enterprise come Red Hat o SUSE, pagando la sottoscrizione, o contrattare supporto esterno. L'assenza di un "prezzo ufficiale" può mascherare costi di personale superiori se mancano competenze Linux interne.

Proxmox VE:

l'Outsider Emergente

Gratuito e open source, con abbonamento facoltativo che costa una frazione di VMware per socket/anno. Popolare nelle PMI, ambienti accademici e contesti con budget limitato, si sta affermando progressivamente anche in ambito enterprise.

Container (Docker & Kubernetes): la Rivoluzione Economica

Docker CE è gratuito, mentre Kubernetes è completamente open source. Le soluzioni enterprise come Red Hat OpenShift o VMware Tanzu hanno modelli di costo specifici. Il vantaggio cruciale: la containerizzazione elimina la necessità di licenze OS per ogni container. Su un host Linux, l'unica potenziale licenza è quella del sistema host, abbattendo radicalmente i costi totali rispetto a 100 VM con licenza Windows.

9.2. L'Economia delle Risorse: Come Evitare gli Sprechi

L'Overhead Invisibile delle VM

Ogni VM carica un sistema operativo completo, con consumi significativi di RAM, CPU e storage. Un'applicazione che richiede 1 GB di RAM potrebbe necessitarne 2-3 GB in una VM. L'hypervisor aggiunge un overhead contenuto (5-10%), mentre l'overcommitment è possibile ma richiede pianificazione attenta.

Container: La Densità Come Vantaggio Strategico

Un container carica esclusivamente le librerie essenziali all'applicazione, senza kernel separato. Su un singolo host è possibile orchestrare decine di container senza saturare le risorse, con risparmi hardware drammatici, particolarmente nei cloud pubblici dove si paga per risorsa consumata.

Economia di Scala

Espandere un cluster VMware implica licenze aggiuntive per socket, mentre con KVM/Proxmox l'espansione non comporta costi incrementali. In ambienti di grandi dimensioni, questo si traduce in risparmi sostanziali, specialmente per infrastrutture di sviluppo/test.

9.3. Il Capitale Umano: l'Investimento Nascosto

Le Competenze: la Valuta Invisibile

VMware e Hyper-V sono tecnologie consolidate con ampia disponibilità di competenze. KVM/Proxmox richiedono conoscenze Linux più approfondite, mentre container e Kubernetes necessitano di skill DevOps specializzate (Dockerfile, Helm, kubectl). Queste figure professionali sono altamente richieste e ben remunerate, rendendo il loro reclutamento un investimento considerevole.

La Manutenzione Continua: il Costo nel Tempo

Con 500 VM occorre mantenere aggiornati sia l'hypervisor sia ogni OS guest, un onere operativo significativo. Con i container, la gestione si sposta a livello di immagine, semplificando l'aggiornamento ma richiedendo processi automatizzati di build e sicurezza delle immagini.

L'Ecosistema di Strumenti: il Costo dell'Integrazione

Nel mondo VM esistono soluzioni mature di backup, disaster recovery e monitoraggio che semplificano le operazioni, ma spesso richiedono investimenti aggiuntivi. L'universo container offre numerose soluzioni open source che necessitano però di integrazione e configurazione, oppure servizi cloud gestiti con costi proporzionali al consumo.

9.4. TCO (Total Cost of Ownership) a 5 Anni: La Visione d'Insieme

Scenario 1: Infrastruttura di 100 VM

VMware: ~30k euro/anno per licenze su 4 host dual-socket, più manutenzione hardware e licenze OS guest.

Proxmox: costo software nullo o poche migliaia con sottoscrizione enterprise, potenziale maggior investimento in formazione.

Hyper-V: licenze Windows Server Datacenter per 4 host (>20k euro, ma potenzialmente "incluse" in contratti EA Microsoft).

KVM (oVirt): open source, nessuna licenza diretta, ma potenziali costi di supporto e competenze.

Scenario 2: Nuovi Microservizi

Opzione VM: 50 VM su cluster VMware, con overhead notevole, provisioning lento e costi licenza OS.

Opzione Container: cluster Kubernetes su 3-5 nodi fisici o VM, con microservizi in container replicati. Minor costo hardware ma investimento in competenze DevOps.

In molti casi, l'opzione container risulta più conveniente e scalabile, specialmente per applicazioni cloud-native.

Scenario 3: Applicazioni Enterprise ad Alta Disponibilità

Approccio VM: Cluster VMware con HA/DRS, licenze Enterprise Plus, storage enterprise, backup Veeam. Costo quinquennale significativo ma con garanzie di supporto e compatibilità certificata.

Approccio Container: Kubernetes in high-availability con storage distribuito, monitoraggio e backup open source. Costo inferiore delle licenze ma investimento superiore in formazione e integrazione.

Il divario economico si riduce considerando i costi nascosti: onboarding, documentazione interna, certificazioni e procedure di recovery.

Scenario 4: Ambiente Ibrido Cloud-On Premises

Le soluzioni ibride beneficiano dell'uniformità tecnologica, con i container che offrono il vantaggio di deployment identici in cloud o localmente.

Il risparmio si estende alla flessibilità strategica di spostare carichi di lavoro in risposta a cambiamenti nelle condizioni di mercato o nei modelli di pricing.

Conclusioni

Nella battaglia tra container e VM non esiste un vincitore universale. Le organizzazioni più evolute hanno compreso che la vera saggezza risiede nella coesistenza strategica.

Verso un Modello di Stratificazione

L'approccio maturo prevede una stratificazione intelligente:

Livello infrastrutturale: hypervisor su hardware fisico, per isolamento e gestione delle risorse di base.

Livello applicativo: container orchestrati su VM selezionate, per agilità e scalabilità.

Isole speciali: VM dedicate per workload legacy, database critici e servizi che richiedono isolamento totale.

Le Domande Guida

Al momento della decisione, considerare:

L'applicazione richiede un sistema operativo specifico?

È necessario isolamento hardware completo?

Quanto è importante la portabilità tra ambienti?

Con quale frequenza l'applicazione sarà aggiornata?

Quali competenze sono disponibili nel team?

Esistono vincoli di compliance determinanti?

Il Futuro è Fluido

Il panorama tecnologico continua a evolversi con tecnologie come i "micro-VM" (Firecracker, Kata Containers) e sistemi operativi immutabili per container (NixOS, Flatcar Linux, Talos).

L'azienda vincente non sarà quella che sceglie dogmaticamente una tecnologia, ma quella che costruisce un'architettura flessibile, capace di integrare l'innovazione senza sacrificare stabilità e sicurezza.

In questo viaggio evolutivo, container e VM sono alleati complementari nella costruzione di infrastrutture digitali resilienti, efficienti e pronte per le sfide future.