Virual Machine o Container? (Part.1)

Virtual Machine o Container? Non è solo una scelta tecnica: è una decisione strategica che impatta su costi, scalabilità, sicurezza e futuro della tua infrastruttura. Abbiamo pubblicato la prima parte di un approfondimento tecnico in 3 episodi: una guida chiara e approfondita per chi vuole davvero capire le differenze tra VM e Container. Scopri la PRIMA PARTE!

IN PRIMA PAGINARETI E INFRASTRUTTURE DIGITALIINNOVAZIONE E TECNOLOGIE EMERGENTI

Prefazione: Un Viaggio attraverso i Sentieri Evolutivi dell'Informatica

Nel panorama dell'informatica enterprise, le tecnologie nascono, evolvono e si trasformano a una velocità che sfida persino l'immaginazione. Due paradigmi hanno ridefinito radicalmente il modo in cui progettiamo, distribuiamo e gestiamo le applicazioni: la virtualizzazione e la containerizzazione.

Là dove un tempo i server erano monoliti dedicati a singole applicazioni, oggi parliamo di infrastrutture elastiche, intelligenti, capaci di adattarsi con l'agilità di un organismo vivente. Questa evoluzione va oltre il semplice progresso tecnico—rappresenta un profondo cambiamento culturale nel modo di concepire l'elaborazione digitale.

1. Introduzione: Tracciare la Nostra Spedizione Tecnologica

Il Contesto Storico

Agli inizi degli anni 2000, la virtualizzazione emerse come una rivoluzione silenziosa. Un singolo server fisico poteva ora ospitare molteplici sistemi operativi, frammentando le risorse hardware con un'eleganza prima impensabile. Gli hypervisor—software miracolosi—trasformarono data center rigidi in ecosistemi dinamici e flessibili.

Ma l'innovazione non si è fermata qui. L'ultimo decennio ha visto l'ascesa dei container, una tecnologia che ha spostato l'astrazione dal livello hardware a quello dei processi.

Obiettivi dell'Analisi

Questo articolo si propone di:

Esplorare approfonditamente virtualizzazione e containerizzazione

Analizzare le principali soluzioni tecnologiche

Confrontare performance, sicurezza e casi d'uso

Fornire linee guida per architetti IT, system administrator e decision maker

Struttura Complessiva dell'Articolo

L'analisi si articolerà in quattro parti principali:

Parte 1 – Introduzione, Fondamenti di Virtualizzazione, Piattaforme di Virtualizzazione, Architettura Docker, Confronto Architetturale.

Parte 2 – Casi d'uso, Scalabilità e Alta Disponibilità, Analisi Costi e Risorse.

Parte 3 – Sicurezza (VM vs Container), Adozione e Quote di Mercato, Linux vs Windows.

Parte 4 – DevOps e Cloud-Native, Best Practice e Considerazioni Finali, Appendici e Risorse.

1.1. Contesto e Obiettivi dell'Articolo

Nel mondo dell'IT enterprise, assistiamo da anni a un'evoluzione costante dei metodi per distribuire e gestire le applicazioni. Negli anni 2000 si è diffusa la virtualizzazione classica con le macchine virtuali (VM): grazie a un hypervisor, un singolo server fisico poteva ospitare più istanze di sistemi operativi differenti.

Nello scorso decennio, tuttavia, abbiamo assistito a una rivoluzione ulteriore: la containerizzazione. Strumenti come Docker hanno spostato il livello di astrazione dall'hardware (o dall'emulazione di hardware) all'isolamento dei processi sul sistema operativo.

Esploreremo in modo approfondito:

Come funzionano la virtualizzazione classica e i container

Le principali soluzioni di virtualizzazione

Le caratteristiche di Docker come tecnologia di containerizzazione

Confronti dettagliati su performance, sicurezza, costi, casi d'uso

L'adozione in ambito enterprise, i trend di mercato e le preferenze tra Linux e Windows

L'integrazione con il mondo DevOps e le architetture cloud-native

L'obiettivo finale è fornire linee guida utili per architetti IT, system admin, CTO e decision maker, permettendo loro di scegliere con consapevolezza la migliore strategia di distribuzione delle applicazioni. Una strategia che, spesso, combina virtualizzazione e container, e non li vede affatto come tecnologie in reciproca esclusione.

1.2. Panoramica delle Tecnologie Coperte

Nel corso dell'articolo, parleremo in particolare di:

Virtualizzazione classica basata su hypervisor:

VMware vSphere (ESXi): leader di mercato enterprise, hypervisor bare-metal di tipo 1 con un ricco ecosistema di strumenti (vCenter, vMotion, DRS, HA…).

Microsoft Hyper‑V: incluso in Windows Server, anch'esso bare-metal (tipo 1), con un approccio a microkernel e integrazione nativa nell'ecosistema Microsoft.

KVM (Kernel-based Virtual Machine): una tecnologia di virtualizzazione open source, parte integrante del kernel Linux, utilizzata da soluzioni come oVirt, Red Hat Virtualization, OpenStack e da tanti fornitori cloud (AWS, GCP) in forma personalizzata.

Proxmox VE: piattaforma open source basata su Debian che unisce KVM per le VM e LXC per i container a livello di sistema operativo, fornendo un'interfaccia web completa e funzionalità cluster/HA.

Containerizzazione:

Docker come runtime e formato di container più popolare.

Le funzionalità chiave che differenziano i container dalle VM.

Il tema dell'orchestrazione (Kubernetes, Docker Swarm, ecc.) come estensione naturale quando si parla di container in produzione.

1.3. Virtualizzazione vs Container: perché il confronto è rilevante oggi

Nel 2023-2025, la virtualizzazione è una tecnologia matura e consolidata. Allo stesso tempo, l'adozione di container è diventata onnipresente per i nuovi sviluppi applicativi, grazie alla loro leggerezza, velocità di avvio e integrazione con i flussi DevOps (continuous integration e delivery, microservizi, cloud-native design).

Spesso le aziende si ritrovano a coordinare entrambi gli approcci:

Da un lato, le VM per isolare applicazioni legacy o sistemi operativi eterogenei.

Dall'altro, i container per le app moderne, i microservizi e i progetti in evoluzione rapida.

Comprendere i fondamenti di entrambi, e come integrarli, diventa cruciale per una strategia IT a lungo termine. Inoltre, l'aspetto dei costi (licenze di hypervisor, overhead hardware, team specializzati) incide in modo decisivo.

La nascita di alternative open source (come Proxmox per la virtualizzazione, e Docker/Kubernetes in ambito container) ha cambiato notevolmente l'equilibrio competitivo con i vendor tradizionali.

1.4. Metodologia di Confronto (Criteri)

Per analizzare a fondo le differenze e i pro/contro tra macchine virtuali e container, utilizzeremo diversi criteri:

Architettura e funzionamento: come operano hypervisor e container runtime.

Performance e overhead: impatto in termini di CPU, RAM, I/O, velocità di avvio.

Sicurezza: livello di isolamento, potenziali vulnerabilità, best practice.

Scalabilità e Alta Disponibilità: meccanismi di clustering, failover e auto-scaling.

Costi: licenze, Total Cost of Ownership (TCO), investimenti hardware, costo operativo di gestione e competenze.

Casi d'uso: situazioni in cui una o l'altra tecnologia si dimostra più adatta.

Adozione sul mercato: statistiche di diffusione, preferenze Windows vs Linux, integrazioni con DevOps e cloud-native.

Ogni sezione offrirà spunti teorici e pratici, con tabelle comparative, dati aggiornati e considerazioni basate su esperienze reali di aziende.

2. Fondamenti di Virtualizzazione

2.1 Concetti Base della Virtualizzazione: Host, Guest e Hypervisor

La virtualizzazione è una tecnologia rivoluzionaria che consente l'esecuzione di molteplici sistemi operativi (definiti "guest") su un'unica infrastruttura hardware fisica (chiamata "host"). Questo prodigio tecnologico è coordinato da un sofisticato livello software denominato hypervisor (o Virtual Machine Monitor, VMM), che distribuisce dinamicamente le risorse computazionali – inclusi CPU, RAM, spazio su disco e capacità di rete – allocandole in modo efficiente e isolato tra i diversi ambienti virtuali.

L'hypervisor opera come un "direttore d'orchestra" digitale, gestendo con precisione chirurgica l'assegnazione e la condivisione delle risorse hardware, garantendo che ogni macchina virtuale disponga delle risorse necessarie senza interferenze o sovrapposizioni con gli altri ambienti.

I benefici storicamente associati alla virtualizzazione sono molteplici e profondi:

Consolidamento dei server: Riduzione significativa del numero di macchine fisiche, ottimizzando l'utilizzo dell'hardware e riducendo i costi infrastrutturali.

Flessibilità operativa: Capacità di creare, clonare e spostare macchine virtuali con una agilità prima impensabile, senza alcun impatto sull'infrastruttura fisica sottostante.

Ottimizzazione dinamica delle risorse: L'hypervisor può implementare sofisticate strategie di bilanciamento del carico e persino "overcommit" delle risorse, come l'assegnazione di memoria virtuale superiore alla RAM fisica disponibile, sfruttando l'intelligente presupposto che non tutte le macchine virtuali utilizzeranno simultaneamente l'intera memoria allocata.

Disaccoppiamento hardware-software: Semplificazione radicale della gestione dei cicli di vita delle macchine, pianificazione di disaster recovery e scalabilità infrastrutturale.

Questa tecnologia rappresenta molto più di un semplice espediente tecnico: è una ridefinizione fundamentale di come concettualizziamo e gestiamo le risorse computazionali, permettendo un'elasticità e un'efficienza prima impensabili nel mondo dell'elaborazione digitale.

2.2 Tipologie di Hypervisor: Type 1 vs Type 2

Gli hypervisor si distinguono tradizionalmente in due categorie fondamentali, ciascuna con caratteristiche e contesti di impiego distintivi:

Tipo 1 (bare-metal): Questi hypervisor rappresentano l'incarnazione più pura della virtualizzazione, installandosi direttamente sull'hardware senza la mediazione di un sistema operativo sottostante. Esempi di eccellenza in questa categoria includono VMware ESXi, Microsoft Hyper-V (integrato in Windows Server ma operante sostanzialmente a livello bare-metal), Citrix XenServer e Nutanix AHV.

Tipo 2 (hosted): Contraddistinti da una natura più "ospite", questi hypervisor si installano come layer software su un sistema operativo preesistente. Esponenti tipici di questa classe sono VMware Workstation, Oracle VirtualBox e Parallels.

Nei complessi ecosistemi dei data center enterprise, la scelta ricade quasi invariabilmente sugli hypervisor di tipo 1. Le ragioni sono cruciali: prestazioni superiori, affidabilità e un profilo di sicurezza significativamente più robusto, derivante dalla minimizzazione degli strati software tra l'hardware e le macchine virtuali.

Per contro, negli ambienti desktop o dedicati a test e sviluppo, strumenti come VirtualBox o VMware Workstation (tipo 2) mantengono un ruolo centrale per la loro facilità di utilizzo e flessibilità.

2.3 Evoluzione Storica: Dal Mainframe al Cloud Computing

La virtualizzazione non è un concetto nato con le tecnologie moderne, bensì affonda le radici in un passato tecnologico ricco di innovazioni. Già negli anni '60 e '70, IBM pioneristicamente sviluppava sistemi mainframe con sofisticati partizionamenti logici (LPAR), dimostrando una visione lungimirante della condivisione delle risorse computazionali.

Il vero punto di svolta si è verificato nei primi anni 2000, quando VMware ha reso concretamente praticabile l'esecuzione di sistemi x86 virtualizzati con un overhead computazionale significativamente ridotto. L'introduzione delle istruzioni CPU Intel VT-x e AMD-V ha successivamente rivoluzionato il panorama, introducendo l'hardware-assisted virtualization come standard di fatto, che ha ulteriormente ottimizzato le prestazioni e ridotto il carico di emulazione.

Oggi, la virtualizzazione non è semplicemente una tecnologia, ma il fondamento architetturale di pressoché ogni infrastruttura cloud, inclusi giganti come AWS e Azure. Questi provider hanno persino sviluppato hypervisor custom, come l'AWS Nitro, basato su KVM, che rappresentano l'evoluzione più avanzata di questo paradigma tecnologico.

2.4 Benefici Generali della Virtualizzazione in Ambito Enterprise

Le aziende hanno abbracciato massicciamente le macchine virtuali negli ultimi 15 anni per una serie di motivazioni strategiche e operative:

Riduzione del Total Cost of Ownership (TCO): Meno server fisici significano minori costi di acquisto, manutenzione, energia e raffreddamento. Un'ottimizzazione economica diretta e sostanziale.

Alta Disponibilità e Continuità Operativa: Funzionalità come vMotion (VMware) o Live Migration (Hyper-V) consentono di spostare macchine virtuali "a caldo" tra host diversi, abilitando operazioni di manutenzione hardware senza alcuna interruzione dei servizi.

Disaster Recovery Semplificato: La natura intrinsecamente software delle VM rende incredibilmente più agevole replicare, spostare e ripristinare ambienti su siti remoti, riducendo significativamente i tempi e i rischi di ripristino.

Flessibilità di Provisioning: Capacità di creare rapidamente nuove macchine virtuali per test, sviluppo, formazione o per gestire picchi stagionali di carico, tutto con pochi click.

In sintesi, la virtualizzazione non è più solo una tecnologia: è diventata un pilastro infrastrutturale irrinunciabile per qualsiasi data center che aspiri a efficienza, resilienza e agilità operativa.

3. Panoramica delle Piattaforme di Virtualizzazione

3.1 VMware vSphere (ESXi):

L'Architettura Enterprise

Architettura Tecnica: Oltre il Tradizionale Concetto di Sistema Operativo

VMware ESXi rappresenta l'evoluzione più raffinata del concetto di hypervisor, basandosi su un microkernel proprietario chiamato "VMkernel". A differenza delle architetture tradizionali, ESXi abbatte il paradigma del sistema operativo, installandosi direttamente sull'hardware server con un'impronta minimalista ed estremamente efficiente.

Le caratteristiche distintive includono:

Driver hardware modulari e iperspecializzati

Ottimizzazione delle performance a livello di singolo ciclo di clock

Isolamento di sicurezza intrinseco nell'architettura

vCenter: Il Cervello Orchestratore dell'Infrastruttura Virtuale

vCenter Server si configura non come un semplice strumento di gestione, ma come un vero e proprio sistema operativo dell'infrastruttura virtuale. Le sue capacità superano la banale amministrazione:

Gestione di migliaia di host in un unico contesto

Orchestrazione di clustering complessi

Bilanciamento dinamico delle risorse computazionali

Funzionalità Rivoluzionarie

vMotion: Migrazione "live" delle macchine virtuali, un concetto che ridefinisce la continuità operativa

DRS (Distributed Resource Scheduler): Intelligenza artificiale applicata al bilanciamento dei carichi

HA (High Availability): Failover automatico con precisione chirurgica

Snapshot: Cattura istantanea degli stati di sistema per ripristino e test

Ecosistema VMware: Più di un Semplice Hypervisor

VMware ha costruito un ecosistema enterprise che include:

vSAN: Storage virtuale iperconvergente

NSX: Virtualizzazione di rete e microsegmentazione

vRealize: Suite per automazione e monitoraggio

Tanzu: Integrazione nativa di piattaforme Kubernetes

3.2 Microsoft Hyper-V:

Integrazione Nativa con l'Ecosistema Windows

Architettura: Hypervisor Strettamente Integrato

Hyper-V rappresenta l'implementazione Microsoft della virtualizzazione, un hypervisor ibrido che si colloca in uno spazio unico tra i modelli tradizionali. Elemento caratterizzante è la "parent partition" di Windows Server, che ospita i driver di I/O, mentre un microkernel hypervisor opera al livello più basso.

Componenti di Gestione

Hyper-V Manager: Interfaccia grafica intuitiva

PowerShell: Strumento di automazione enterprise

System Center VMM: Soluzione per infrastrutture complesse

Punti di Forza

Integrazione profonda con Windows Server

Licenze incluse senza costi aggiuntivi

Architettura ibrida cloud-ready

Failover Clustering per alta disponibilità

Strategia Cloud e Visione Futura

Stretta integrazione con Azure Stack HCI

Architettura sottostante del cloud pubblico Azure

Supporto nativo per ambienti ibridi e cloud-native

3.3 KVM:

Quando il Kernel Linux Diventa un Hypervisor Rivoluzionario

La storia di KVM è un racconto di innovazione dirompente. Immaginatelo come un alchimista digitale che trasforma il kernel Linux in qualcosa di più di un semplice sistema operativo: un hypervisor capace di moltiplicare la potenza computazionale con un'eleganza disarmante.

L'Architettura di una Rivoluzione Silenziosa

KVM non è semplicemente un modulo software, ma una filosofia della virtualizzazione. Nato dall'intuizione che il kernel Linux potesse essere molto più di un gestore di risorse, rappresenta l'apoteosi del movimento open source: rendere potente ciò che era considerato limitato.

Il suo cuore pulsante, il modulo "kvm.ko", opera come un regista invisibile che coordina l'esecuzione di molteplici macchine virtuali. Sfruttando le estensioni di virtualizzazione Intel VT-x e AMD-V, KVM abbatte i confini tra hardware e software, creando ambienti virtuali che sfiorano le prestazioni del "bare metal".

QEMU, il suo fedele compagno, non è un semplice emulatore, ma un artista che ricrea mondi digitali. Emula con precisione chirurgica ogni componente hardware: dal BIOS più obsoleto alle schede di rete più moderne, permettendo l'esecuzione di sistemi operativi completamente isolati e indipendenti.

Ecosistemi e Metamorfosi

La vera forza di KVM risiede nella sua capacità di evolversi. Non è relegato a un singolo utilizzo, ma si manifesta in molteplici forme:

Nei data center di Red Hat, dove diventa l'architrave di interi ecosistemi cloud

Nelle infrastrutture iperconvergenti di Nutanix, dove plasma ambienti di calcolo estremamente flessibili

Nei cloud pubblici di Amazon e Google, dove viene raffinato fino a diventare quasi irriconoscibile

I suoi driver virtIO sono come dei traduttori simultanei che permettono alle macchine virtuali di comunicare con l'hardware con una fluidità prima impensabile. Performance, efficienza, leggerezza: KVM ridefinisce questi concetti.

3.4 Proxmox VE:

L'Artigiano Digitale della Virtualizzazione

Se KVM è il filosofo della virtualizzazione, Proxmox VE è l'artigiano che plasma questa filosofia in strumenti concreti e accessibili. Nato dalla comunità Debian, rappresenta l'incarnazione di un'idea rivoluzionaria: rendere la tecnologia enterprise accessibile a tutti.

Un Ecosistema, Infinite Possibilità

Proxmox non è solo un hypervisor. È un racconto di integrazione. KVM e LXC coesistono in un equilibrio dinamico, come due forme di vita digitale che si completano a vicenda. Macchine virtuali e container si intrecciano in un dance floor computazionale, offrendo una flessibilità che lascia a bocca aperta gli architetti IT più esperti.

La sua interfaccia web è una finestra su un mondo di possibilità: dal clustering complesso alla gestione dello storage, tutto è a portata di click. Ma dietro questa semplicità apparente, si nasconde una complessità tecnica degna delle più raffinate architetture enterprise.

Il Modello di un Nuovo Paradigma

Proxmox sfida il modello tradizionale di business nel mondo IT. La sua community edition non è un prodotto di serie ridotto, ma un ecosistema completo e potente. Gli abbonamenti enterprise non vendono un software, ma un'esperienza: aggiornamenti garantiti, supporto professionale, la tranquillità di avere un partner tecnologico.

3.5 Oltre i Giganti:

Tecnologie Complementari

Nel vasto universo della virtualizzazione, esistono mondi paralleli. Xen, Oracle VM, VirtualBox: non sono alternative, ma prospettive diverse sulla stessa realtà digitale. Ciascuno racconta una storia unica di innovazione, adattamento, sopravvivenza tecnologica.

Il Futuro è Già Qui

Il mercato enterprise converge, ma non si uniforma. VMware, Hyper-V, KVM: non sono competitori, ma interpreti di un'orchestra tecnologica sempre più complessa. La vera sfida non è scegliere la migliore tecnologia, ma comprendere quale storia raccontare, quale visione implementare.

La virtualizzazione non è più una tecnologia. È un linguaggio, un modo di immaginare l'infrastruttura IT come un organismo vivo, fluido, in continua evoluzione.

4. Architettura dei Container con Docker

4.1. Concetti base di containerizzazione: isolamento e condivisione del kernel

La containerizzazione rappresenta un paradigma rivoluzionario di isolamento dei processi a livello sistemistico. A differenza della virtualizzazione completa, i container si basano su meccanismi nativi del kernel Linux che consentono un'isolamento leggero ed efficiente.

Elementi chiave di questo approccio includono:

Namespaces: Meccanismi che permettono a ogni container di avere una "vista" isolata delle risorse di sistema, controllando cosa ciascun processo può "vedere" e raggiungere.

Control Groups (cgroups): Strumenti per limitare, misurare e isolare l'utilizzo delle risorse di sistema, garantendo che nessun container possa monopolizzare le risorse dell'host.

Union Filesystem: Tecnologia che consente la creazione di immagini "stratificate", dove ogni layer è immutabile e condivisibile, ottimizzando l'utilizzo dello spazio e la velocità di distribuzione.

Il principio fondamentale è la condivisione del kernel: tutti i container su un host Linux condividono lo stesso nucleo sistemistico, eliminando la necessità di installare un sistema operativo completo per ogni istanza.

4.2. Docker Engine: l'architettura dietro la containerizzazione

Docker Engine rappresenta l'ecosistema completo per la gestione dei container, composto da componenti interconnesse:

Docker Daemon (dockerd): Il servizio centrale che gestisce la creazione, l'esecuzione e la supervisione dei container.

Docker CLI: L'interfaccia a riga di comando che permette agli utenti di interagire con il daemon.

Images: Modelli read-only che contengono le istruzioni per creare un container, memorizzati in registry pubblici o privati.

Quando un container viene avviato, Docker assembla gli strati dell'immagine in sola lettura e crea un layer di scrittura temporaneo, seguendo il modello copy-on-write.

4.3. Tecnologie fondamentali: namespaces, cgroups e overlay filesystem

Approfondendo le tecnologie sottostanti:

Namespaces: Creano un'illusione di ambiente completamente isolato, dove ogni container ha la propria vista di rete, processi, mount point e utenti.

Control Groups: Implementano un meccanismo di controllo granulare su risorse come CPU, memoria e I/O, prevenendo che un singolo container comprometta le prestazioni dell'intero sistema.

Overlay Filesystem: Permettono la condivisione efficiente di strati comuni tra container, caricando una sola volta componenti di base come un'immagine del sistema operativo.

4.4. Docker: differenze tra implementazioni Linux e Windows

Le implementazioni di Docker presentano significative differenze tra piattaforme:

Linux:

Esecuzione nativa

Condivisione diretta del kernel host

Massima efficienza e leggerezza

Windows:

Due modalità di esecuzione principali:

Windows Server Containers: Condivisione del kernel di Windows Server

Hyper-V Isolation: Esecuzione in mini-macchine virtuali per maggiore isolamento

Un limite cruciale: i container Linux non possono essere eseguiti nativamente su kernel Windows, e viceversa.

4.5. Orchestrazione: oltre il singolo host

La gestione di container su singola macchina presenta limiti evidenti. L'orchestrazione diventa quindi essenziale:

Kubernetes: Lo standard de facto per la gestione di container su cluster distribuiti

Scheduling dinamico dei Pod

Auto-sostituzione dei container guasti

Aggiornamenti rolling

Gestione dinamica di rete e storage

Docker Swarm: Soluzione di orchestrazione integrata in Docker, più semplice ma meno diffusa

5. Confronto Architetturale: VM vs Container

5.1. L'Evoluzione degli Stack Computazionali

Immaginate di osservare l'architettura computazionale come un ecosistema in continua trasformazione. Tradizionalmente, le macchine virtuali rappresentavano l'approccio dominante: un mondo di sistemi completamente isolati, ognuno con il proprio sistema operativo, risorse dedicate e confini netti.

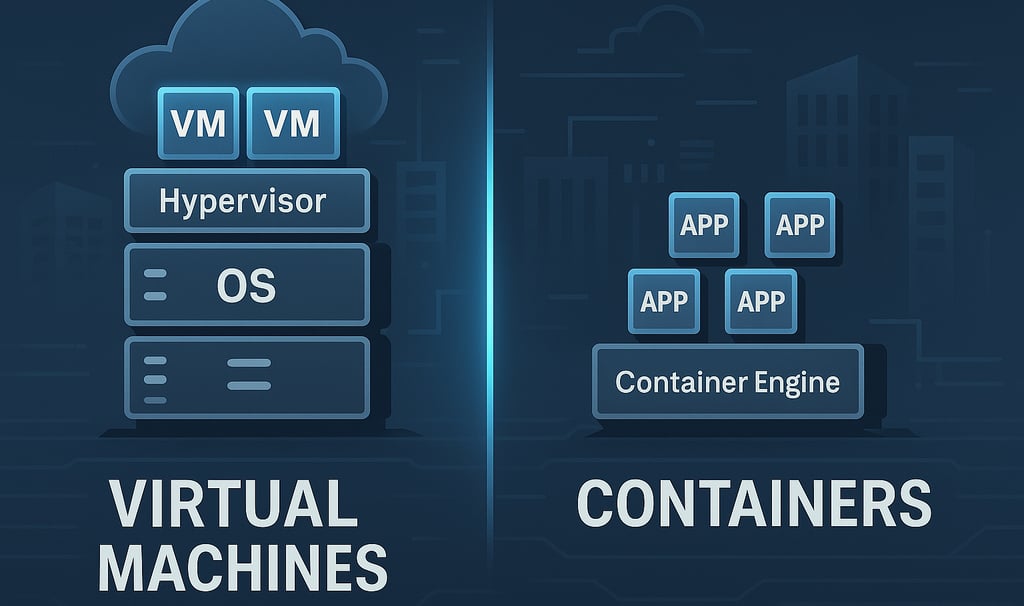

Le macchine virtuali costruiscono il loro mondo su uno stack stratificato:

Un livello hardware fondamentale

Un hypervisor che crea mondi virtuali indipendenti

Sistemi operativi guest completamente autonomi

Applicazioni che risiedono in questi universi isolati

I container, invece, propongono una rivoluzione architettonica: un approccio più fluido, leggero e interconnesso. Il loro stack è essenziale:

Hardware come base

Un unico sistema operativo host

Un runtime per container

Applicazioni che condividono risorse e kernel

5.2. La Sicurezza come Dialogo tra Isolamento e Condivisione

La sicurezza non è più un muro, ma una conversazione dinamica tra isolamento e condivisione. Le macchine virtuali offrono un modello di sicurezza tradizionale: confini invalicabili, dove ogni istanza è un mondo a sé stante, protetto dall'hypervisor come da un fossato medievale.

I container rappresentano invece una filosofia di sicurezza più moderna e sfaccettata. Utilizzano i meccanismi nativi del kernel per creare spazi isolati, ma con una porosità controllata. Sono come appartamenti in un condominio intelligente: separati ma interconnessi, con sistemi di sicurezza condivisi ma personalizzabili.

5.3. Risorse Computazionali: dalla Statica all'Elasticità Dinamica

Nel mondo delle VM, le risorse sono come terreni recintati: a ciascuna macchina virtuale viene assegnato un appezzamento predefinito di CPU, memoria e storage. Lo spreco è accettato come un pedaggio necessario per l'isolamento.

I container sovvertono questo modello. Sono più simili a uno spazio di coworking dinamico, dove le risorse si espandono e si contraggono in tempo reale. I cgroups di Linux diventano l'architetto di questo spazio flessibile, monitorando e regolando l'utilizzo con una precisione chirurgica.

5.4. Networking: Reti che Respirano

Il networking tradizionale delle macchine virtuali è paragonabile a un sistema di comunicazione con confini rigidi: virtual switch, VLAN, port group. Ogni VM ha la sua scheda di rete, come un appartamento con un proprio ingresso rigorosamente separato.

I container introducono invece una rete che respira e si trasforma. I bridge di default, i port mapping, i plugin di rete in ambienti orchestrati come Kubernetes rappresentano un network living, capace di adattarsi dinamicamente alle esigenze applicative.

5.5. Storage: dalla Persistenza Monolitica alla Flessibilità Modulare

Nelle macchine virtuali, lo storage è un mondo chiuso: dischi virtuali dedicati, backup di interi sistemi, uno stato che resiste e permane. È come una biblioteca dove ogni libro è un mondo completo e immodificabile.

I container propongono una visione rivoluzionaria: lo storage come servizio effimero e riconfiguabile. I volumi e i bind mount diventano meccanismi per connettere dati persistenti a container volatili. È un approccio che privilegia la modularità e la ricostruibilità over la conservazione statica.

5.6. Overhead e Risorse: Leggerezza come Filosofia Computazionale

Le macchine virtuali sono sistemi pesanti: diversi gigabyte di RAM per il solo sistema operativo, avvii lenti, risorse riservate ma spesso sottoutilizzate. Sono come auto ingombranti che consumano carburante anche quando sono ferme.

I container incarnano invece l'ideale della leggerezza computazionale. Occupano centinaia di megabyte invece di gigabyte, si avviano in secondi, possono essere ammassati su un singolo hardware con una densità impressionante. Sono veicoli agili, pronti a muoversi e riconfigurasi istantaneamente.

5.7. Scalabilità: dalla Crescita Meccanica all'Espansione Organica

Scalare con le macchine virtuali è un processo meccanico e lento: clonare, provisionare, attendere minuti per nuove istanze. È come costruire nuovi edifici, un processo lungo e complesso.

I container introducono una scalabilità organica: nuove istanze in secondi, capacità di espansione orizzontale immediata, architetture che respirano e si adattano al carico. Non sono più edifici, ma network neurali computazionali che si espandono e si contraggono con intelligenza.

6. Differenze di Funzionamento e Logica

6.1. Ciclo di vita: dal provisioning tradizionale all'istantaneità dei container

Il confronto tra il provisioning di una macchina virtuale e un container rivela una trasformazione radicale nei modelli di deployement:

Una VM tradizionale richiede un processo articolato:

Definizione delle risorse computazionali

Installazione di un sistema operativo completo

Configurazione approfondita dell'ambiente

Installazione di pacchetti e software specifici

Un container, invece, segue un percorso completamente diverso:

Selezione di un'immagine pre-configurata

Download rapido dal registry

Avvio immediato dell'istanza

Questa differenza si traduce in pipeline di continuous deployment estremamente più agili, dove l'intero ambiente è codificato e immediatamente replicabile.

6.2. Deployment e aggiornamenti: dall'evoluzione incrementale all'immutabilità

Nei tradizionali ambienti di virtualizzazione, gli aggiornamenti avvengono "in situ": patch e modifiche vengono applicate direttamente sulla macchina virtuale. Questo approccio comporta rischi significativi, primo tra tutti l'accumulo di configurazioni divergenti e difficilmente tracciabili.

I container introducono un paradigma rivoluzionario: l'immutabilità. Ogni nuovo rilascio comporta la ricostruzione completa dell'immagine con dipendenze aggiornate, sostituendo integralmente l'istanza precedente mediante rolling update.

Questo modello richiede certamente un ecosistema DevOps maturo, ma offre vantaggi sostanziali in termini di riproducibilità e tracciabilità degli ambienti.

6.3. Portabilità: da migrazione complessa a condivisione immediata

Le macchine virtuali, pur supportando esportazioni in formati standard come OVF/OVA, rimangono entità "pesanti", con dipendenze sistemistiche significative e ingombro di diversi gigabyte.

I container incarnano invece il principio "costruisci una volta, esegui ovunque". La condivisione avviene attraverso registry, consentendo una portabilità pressoché istantanea, vincolata unicamente alla compatibilità del container runtime.

Per le architetture cloud-native, questa leggerezza rappresenta un vantaggio competitivo decisivo.

6.4. Gestione: dall'interfaccia grafica alla configurazione come codice

Mentre le piattaforme di virtualizzazione tradizionali (VMware, Hyper-V) offrono interfacce grafiche centralizzate per l'amministrazione, il mondo dei container abbraccia un approccio diametralmente opposto.

La gestione avviene prevalentemente tramite:

Interfacce a riga di comando

File di configurazione dichiarativi (Dockerfile, docker-compose, Kubernetes manifests)

Principi di Infrastructure as Code (IaC)

Questa transizione non è solo un cambiamento tecnico, ma una vera e propria rivoluzione culturale nell'approccio allo sviluppo e al deployment.

6.5. Backup e Disaster Recovery: dalla replica dell'ambiente alla gestione dei dati

Nei sistemi di virtualizzazione tradizionali, il backup è un processo completo che cattura l'intera macchina virtuale: disco, stato e configurazioni. Strumenti come Veeam permettono ripristini completi, ma con procedure spesso complesse e time-consuming.

Nel mondo dei container, il concetto stesso di backup si trasforma:

Il container è considerato effimero

L'attenzione si sposta sui dati persistenti

Il ripristino diventa un processo di ricostruzione dell'infrastruttura e recupero dei volumi

Questa filosofia consente ripristini rapidi e maggiore resilienza complessiva.

6.6. Performance e Ottimizzazione: dal controllo hardware all'efficienza del kernel

Gli hypervisor tradizionali offrono sofisticati meccanismi di ottimizzazione: memory ballooning, deduplicazione della memoria, scheduler CPU avanzati.

I container, operando direttamente sul kernel host, offrono un livello di granularità e controllo ancora più preciso:

Limiti puntuali su CPU e memoria

Latenze potenzialmente ridotte

Maggiore efficienza nelle risorse

Restano tuttavia scenari specifici – come High Performance Computing o ambienti con requisiti kernel particolari – dove le macchine virtuali mantengono un vantaggio competitivo.

Conclusioni Parziali

L'evoluzione da virtualizzazione tradizionale a containerizzazione non è semplicemente un cambiamento tecnologico, ma una trasformazione sistemica nei modelli di sviluppo, deployment e gestione dell'infrastruttura IT.